”词向量与词向量拼接“ 的搜索结果

词向量就是要用某个固定维度的向量去表示单词。也就是说要把单词变成固定维度的向量,作为机器学习(Machine Learning)或深度学习模型的特征向量输入。 from gensim.models import Word2Vec import jieba # 先导入...

深入浅出系列1:词向量 0、文章结构 词向量简介 one-hot编码 统计语言模型 分布式表征和SVD分解 神经网络语言模型 word2vec fastText(新增文章补充,敬请期待) GloVe(新增文章补充,敬请期待) Bert/ELMO/GPT...

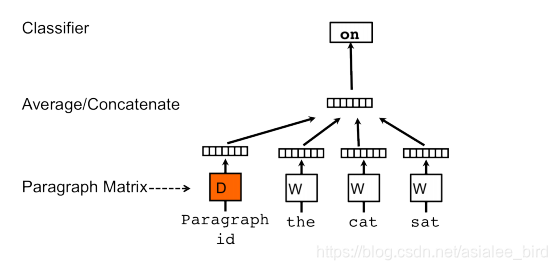

将输入文本中的词通过编码映射到词嵌入矩阵中, 词向量特征经嵌入和平均叠加后, 和基于TF-IDF的文本向量特征进行拼接, 传入到输出层后计算属于每个分类的概率. 该模型在低维词向量的基础上结合了文本向量特征的表达...

语音中,用音频频谱序列向量所构成的矩阵作为模型的输入;在图像中,用图像的像素构成的矩阵数据作为模型的输入。这些都可以很好表示语音/图像数据。而语言高度抽象,很难刻画词语之间的联系,比如“麦克风”和...

词向量要点: 一. Efficient Estimation of Word Representations in Vector Space vector(”King”) - vector(”Man”) + vector(”Woman”) is close to vec(“Queen”) 构建词向量的早期方法有LSA、LDA; NNLM...

python向量拼接和拆分

标签: python

python 向量拼接和拆分 1.pytorch torch.cat(tensors,dim,out) >>> x = torch.randn(2, 3) >>> x tensor([[ 0.6580, -1.0969, -0.4614], [-0.1034, -0.5790, 0.1497]] >>> torch.cat((x...

从古老的one-hot表示法,到大热的Word2vec系列的分布式表示方法,再到现在惊艳的预训练模型ELMo、BERT等,技术迭代迅速,这其中包含...1、词的表示 1、词的表示 1.1 离散表示(one-hot representation) 把每个...

一、什么是词向量 词向量是将字、词语转换成向量矩阵的计算模型。目前为止最常用的词表示方法是 One-hot,这种方法把每个词表示为一个很长的向量。这个向量的维度是词表大小,其中绝大多数元素为 0,只有一个维度的...

这几天做NLP的时候拼接多个词向量来代表一个单词,但是发现每次重启软件得到的词向量都不一样。。吐血debug才发现是集合的问题,把词向量放入集合后按集合中输出的词向量模型来编码,集合的输出顺序具有的随机性导致...

本文重点本文中我们将学习使用文本分类模型TextCNN来完成文本的分类任务,TextCNN是应用卷积神经网络对文本数据进行分类的模型。卷积神经网络的和心思想是捕捉局部特征,对于文本来说,局部特征就是由若干单词组成的...

自然语言处理中一个很核心的基本任务就是语言模型与词向量,这一篇文章我主要回顾了一下自然语言处理中语言模型与词向量的发展历程,总结一下这一条线的一些经典的idea。

gensim word2vec tfidf

词向量

1 大纲概述文本分类这个系列将会有十篇左右,包括基于word2vec预训练的文本分类,与及基于最新的预训练模型(ELMo,BERT等)的文本分类。总共有以下系列:jupyter notebook代码均在textClassifier仓库中,python代码在...

原文: On word embeddings 作者: Sebastian Ruder 译者: KK4SBB 审校:王艺 ...词向量的来历 词向量模型 语言建模概述 经典的神经语言模型 C&W模型 Word2Vec CBOW Skip-gram 非监督式学习得到...

在2003年首先提出了词向量的概念,当时是将其与语言模型的参数一并训练得到的。Collobert和Weston则第一次正式使用预训练的词向量,不仅将词向量方法作为处理下游任务的有效工具,还引入了神经网络模...

WordVec词向量 Bert词向量 Bert本质上是一个两段式的NLP模型。第一个阶段:Pre-training,跟WordEmbedding类似,利用现有无标记的语料训练一个语言模型。第二个阶段:Fine-tuning,利用预训练好的语言模型,完成...

使用句子中出现单词的Vector加权平均进行文本相似度分析虽然简单,但也有比较明显的缺点:没有考虑词序且词向量区别不明确。如下面两个句子:“北京的首都是中国”与“中国的首都是北京”的相似度为1。“学习容易”...

1.基于规则,对于要提取的分类维护一个dict,在dict里面保存需要提取的关键词,存在关键词的对应标记为分类;...(缺点很明显,只有词出现信息,对于词的重要度完全没有体现) 4.tf-idf:先考虑...

连续词袋模型用一个中心词在文本序列前后的背景词来预测该中心词 ∏t=1TP(w(t)∣w(t−m),…,w(t−1),w(t+1),…,w(t+m)).∏t=1TP(w(t)∣w(t−m),…,w(t−1),w(t+1),…,w(t+m)). \prod_{t=1}^T \...

ELMo通过结合大量文本数据训练的语言模型,实现了词义的动态性和上下文敏感性,并且能够有效地提升下游NLP任务的表现。虽然BERT后来在许多方面超越了ELMo,但ELMo仍然是推动NLP领域动态词向量发展的重要里程碑。

一、文本表示和各词向量间的对比 1、文本表示哪些方法? 下面对文本表示进行一个归纳,也就是对于一篇文本可以如何用数学语言表示呢? 基于one-hot、tf-idf、textrank等的bag-of-words; 主题模型:LSA(SVD)、...

在此之前,我们来回顾一下,如果我们想拿到一个句子的特征向量可以采用什么样的方式(ps 这些下方总结只是笔者在工作中学到的一些文本向量抽取方式,可能并未收集齐全):基于词袋模型(Bag of Words)Bag of Words : ...

推荐文章

- Android 编译so文件 MP4V2_android下编译mp4v2-程序员宅基地

- 通讯录Contact_02_contact文件内容-程序员宅基地

- Qt笔记(四十二)之QZXing的编译 配置 使用_qzxingfilterrunnable error:-程序员宅基地

- 关于画图软件Dia打开程序始终为英文界面的问题-程序员宅基地

- OpenCV从入门到精通实战(二)——文档OCR识别(tesseract)-程序员宅基地

- 详解avcodec_receive_packet 11_avcodec_receive_packet eagain-程序员宅基地

- OpenGL SuperBible 7th源码编译记录_superbible7-media github-程序员宅基地

- Wireshark简单使用-程序员宅基地

- MXNet 粗糙的使用指南_iou loss mxnet-程序员宅基地

- iOS对ipa包进行代码混淆《二》 ---代码混淆_ipa包混淆-程序员宅基地