模型压缩总结 1. 核参数稀疏 在损失函数中添加使得参数趋向于稀疏的项, 使得模型在训练过程中,其参数权重趋向于稀疏。 2. 权重矩阵低秩分解 核心思想就是把较大的卷积核分解为两个级联的行卷积核和列卷积核, 例如...

”模型压缩“ 的搜索结果

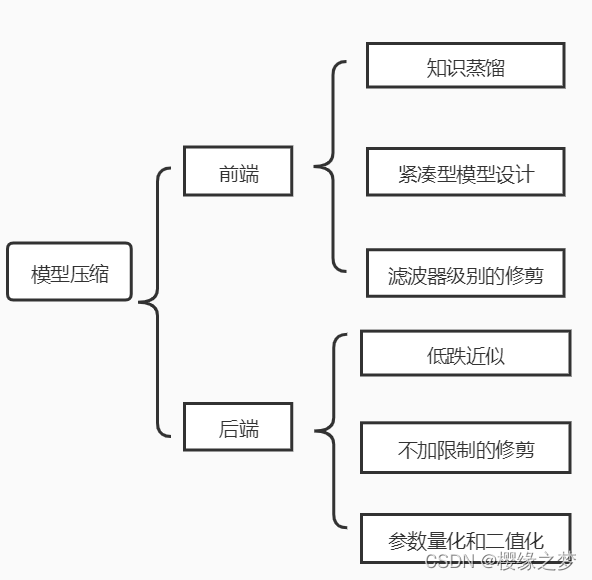

模型压缩技术的主要目标是将大型的深度学习模型压缩为较小的模型,以便在资源受限的设备上进行推理。这种压缩方法可以减少存储需求,提高计算效率,并降低能耗。 在本文中,我们将讨论模型压缩的核心...

1.背景介绍 在当今的大数据时代,人工智能(AI)技术已经...因此,模型压缩和加速变得至关重要。 知识蒸馏(Knowledge Distillation, KD)是一种将大型模型(teacher model)的知识转移到小型模型(student model)上的方...

之前陆陆续续看了许多模型压缩相关的文章,自己业务中也接触过一些相关的客户,今天周末没事做,把模型压缩相关的内容整理一下做个分享。可能更多地从科普的角度去介绍,因为我也不是专业做这方面技术的研究。 首先...

作者:禅与计算机程序设计艺术 近年来,随着计算机算力的提升、...但是,由于模型训练需要大量数据,因此模型大小会成为一个重要的瓶颈。另一方面,迁移学习的普及也使得少量数据的样本也可以对预训练模型进行微调,其

模型压缩技术可以将大型模型压缩为较小的模型,从而降低模型的存储和计算成本,同时保持模型的性能。 在过去的几年里,我们已经看到了许多模型压缩技术的发展,如量化、剪枝、知识蒸馏等。然而,这些技术仍然存在...

因此,模型压缩技术成为了一种重要的研究方向,旨在减少模型的大小和计算复杂度,同时保持或提高模型的性能。 模型压缩的主要方法有三种:1) 权重裁剪,2) 权重量化,3) 知识蒸馏。权重裁剪通过消除...

知识蒸馏在模型压缩中的应用 1. 背景介绍 随着深度学习技术的飞速发展,模型的复杂度也日益提高。大型深度神经网络模型通常会包含数亿个参数,这不仅会带来高昂的计算和存储开销,还会影响模型的推理

蒸馏学习(Distillation)是一种新兴的人工智能技术,它通过将一个大型模型(称为“教师模型”)与一个较小的模型(称为“学生模型”)结合,来实现模型压缩和高效推理。这种方法的核心思想是将知识从大型模型传输到较小...

随着大模型规模的迅猛增长,每年以指数...为了在保持模型性能的基础上降低开销,研究者们提出了多种模型压缩与优化的方法。本文将深入探讨模型剪枝、知识蒸馏、模型量化以及其他压缩方法,并介绍了架构搜索的新颖思路。

1.背景介绍 人工智能(Artificial Intelligence, AI)是一门研究如何让计算机模拟人类智能的科学。在过去的几十年里,我们已经取得了显著的进展,例如自然语言处理(Natural Language Processing, NLP)、计算机视觉...

在深度学习模型的应用中,模型压缩是一个重要的研究方向。模型压缩的目的是在保持模型性能的前提下,降低模型的大小,从而减少内存占用和计算开销。模型压缩可以分为两类:一是量化压缩,二是剪枝压缩。量化压缩通过...

1.背景介绍 ...本文将从模型压缩的应用场景入手,深入探讨图像识别和自然语言处理中的模型压缩技术,揭示其核心概念、算法原理和具体操作步骤,以及未来发展趋势与挑战。 2.核心概念与联系 模型...

探索 YuanLiMM:一款高效的深度学习模型压缩工具 项目地址:https://gitcode.com/bydmm/yuanlimm 简介 在深度学习领域,模型大小和计算效率是影响其应用广泛度的关键因素。YuanLiMM 是一个开源项目,旨在通过模型剪枝...

CNN模型压缩总结 总结综述 参考:https://blog.csdn.net/shentanyue/article/details/83508497 模型裁剪/剪枝(Pruning) 单个权重(Weight)剪枝——非结构化 定义:任意权重被看作是单个参数并进行随机非结构...

作者:禅与计算机程序设计艺术 "模型压缩与可解释性:如何在保护模型隐私的同时提高模型的可解释性" 引言 1.1. 背景介绍

为了解决这些问题,压缩模型以最大限度地减小模型对于计算空间和时间的消耗。 2.理论基础 必要性:目前主流的网络,如VGG16,参数量1亿3千多万,占用500多MB空间,需要进行300多亿次浮点运算才能完成一次图像...

大家好,我是小P,今天给大家带来深度模型压缩经典文献MobileNets的解读,关于轻量化模型的介绍,资料齐全。 此外,对“目标检测/模型压缩/语义分割”感兴趣的小伙伴,欢迎加入QQ群 813221712 讨论交流,进群请看群...

分块压缩感知,算法是基于OMP算法,变换是DCT变化,且根据纹理自适应选择 分块压缩感知,算法是基于OMP算法,变换是DCT变化,且根据纹理自适应选择

YOLOv5模型压缩方法:综述

标签: YOLO

在过去的几年里,广泛的研究致力于增强YOLO目标检测器。...利用模型压缩方法的丰硕成果,如降低内存使用和推理时间,使其有利于在硬件受限的边缘设备上部署大型神经网络。本文的重点是修剪和量化,因为它们比较模块化。

最近因为项目的需要,我们需要将tensorflow模型部署到手机端,所以必不可少的就是模型的优化加速和模型压缩,我这个文章主要是为了记录一下使用到的方法。...

推荐文章

- Jeston TX2-配置中文输入法_tx2 genghuanyuyan-程序员宅基地

- 安装配置Visual Studio Code Kubernetes Tools_vscode visual studio k5-程序员宅基地

- pip安装命令_pipanzhuangming;-程序员宅基地

- Cisco技术区常用配置实例整理----2010.11.1更新ing....-程序员宅基地

- Linux grep命令详解-程序员宅基地

- 贪心算法解决汽车加油问题_实验3.3 汽车加油问题 1、问题描述:一辆汽车加满油后可行驶nkm。旅途中有若干加油-程序员宅基地

- windows下使用makefile编译C语言.doc_windows编译c文件make-程序员宅基地

- moviepy音视频剪辑:与大小相关的视频变换函数详解_moviepy 抖音视频大小-程序员宅基地

- JAVA基础知识点总结-程序员宅基地

- 58、NeuMan: Neural Human Radiance Field from a Single Video-程序员宅基地