最近在研究深度学习的模型压缩,看到几篇总结的很不错的文章,记录一下。 转:https://blog.csdn.net/wspba/article/details/75671573 前言 目前在深度学习领域分类两个派别,一派为学院派,研究强大、复杂的...

”模型压缩“ 的搜索结果

机器学习模型压缩相关文献、工具、学习资料列表

模型压缩

环境准备: 1.下载drac源码:... 2.所用环境:windows10,cmake,vs2015,unity 编译drac: 1.drac源码文件中新建build文件,cmd中进入build文件夹,使用一下命令编译源码: ...2.用vs2015打开build下vs解决方...

模型压缩- 剪枝/量化/蒸馏/AutoML 原因:深度学习计算复杂度高,参数冗余。 解决方式: (1)线性或非线性量化。 (2)结构或非结构剪枝。 (3)网络结构搜索。 (4)权重矩阵的低秩分解。(蒸馏) 目的: 优化精度...

lm格式并没经过压缩,laya的收费会员就有这功能。经过多种压缩格式,顾及到速度和压缩率,我最后还是采用lzss,先在Unity里开发lzss压缩lm的代码。压缩后,在laya.d3.js里的_onMeshLmLoaded里解压数据,问题即可解决...

https://www.cnblogs.com/shixiangwan/p/9015010.html

因为传统训练好的卷积核存在着低秩特性,因此常用的压缩方法里就会采用低秩分解(SVD)的方法进行压缩,但时这种压缩存在一些不足: 若卷积核不低秩,那压不了呗 即使是低秩的,压缩之后精度受损,需要re-training ...

模型压缩原因 论文Predicting parameters in deep learning提出,其实在很多深度的神经网络中存在着显著的冗余。仅仅使用很少一部分(5%)权值就足以预测剩余的权值。该论文还提出这些剩下的权值甚至可以直接不用被...

MobileID:通过将知识从神经元中蒸馏出来的面部模型压缩

在深度学习领域,模型压缩和优化是两个非常重要的方面。模型压缩可以帮助我们减少模型的大小,从而降低存储和计算开销。模型优化则可以提高模型的性能,使其在同样的计算资源下能够达到更高的准确率。在本文中,我们...

深度学习模型参数太多,本地服务器部署没有问题,但是如果部署到移动端、边缘端,像手机、树莓派等,它们的性能不能满足,所以我们要压缩模型大小,让他们可以部署到边缘端。

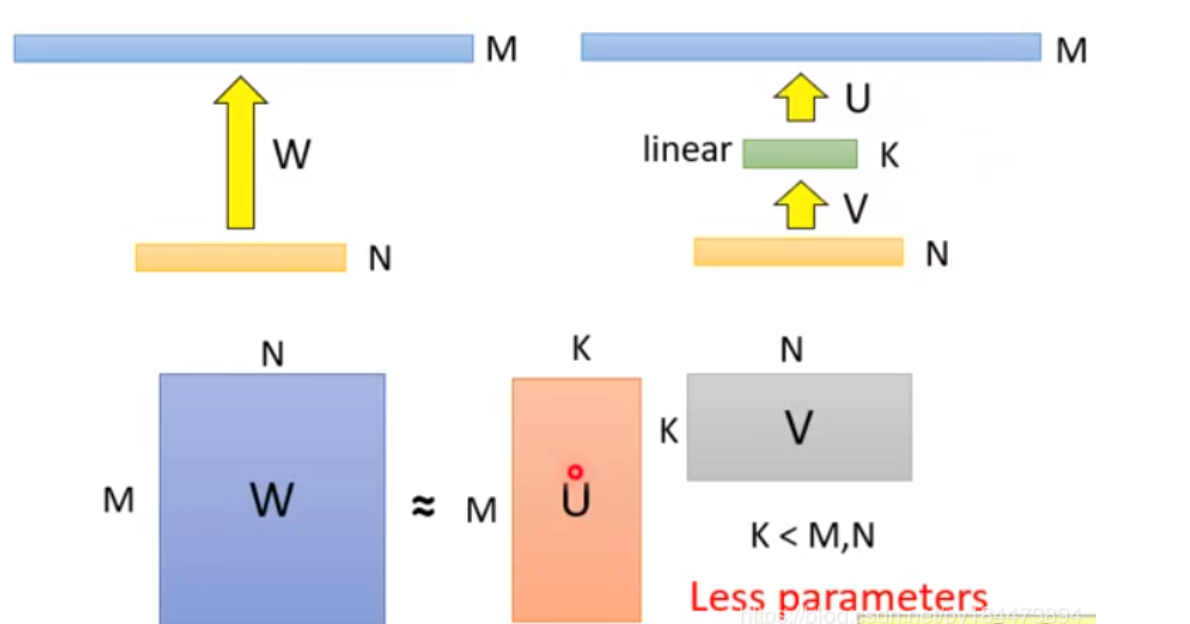

矩阵分解法被广泛地应用于线性模型的加速以及参数的压缩上,具体方法是使用奇异值分解的方式对参数矩阵进行分解。奇异值分解有很明显的物理意义,即它可以将一个复杂矩阵用几个小矩阵相乘来表示,这些小的矩阵描述的...

摘要 在神经网络模型中,通过正则化或剪枝来诱导稀疏性是压缩网络的一种方法(量化是另一种方法)。稀疏神经网络具有速度快、体积小和能量大的优点 ...

模型压缩的基本原理与技巧

标签: 人工智能

模型压缩是一种在保持模型性能的同时降低模型大小的技术,主要应用于深度学习和人工智能领域。随着数据量的增加和计算设备的限制,模型压缩成为了一种必要的技术手段。模型压缩的主要方法包括权重裁剪、量化、知识...

三维模型压缩路线

压缩模型的参数数量、深度来降低模型空间复杂度 全连接层参数多,模型大小由全连接层主导 不显著提高训练时间复杂度,降低预测时间复杂度(计算量) 卷积层计算量大,计算代价由卷积操作主导 2.方法 ...

随着人工智能技术的发展和迅速落地到实际生活场景中,模型压缩技术作为一种重要手段被越来越多地用于解决模型过拟合和资源开销问题。同时,模型压缩也成为许多任务的必备工具,如图像分类、目标检测、文本生成等。而...

Learning Efficient Convolutional Networks through ...2、压缩代码 论文:Network Slimming-Learning Efficient Convolutional Networks through Network Slimming 剪枝项目参考https://github.com/tanluren/yol

深度学习模型的压缩和加速是指利用神经网络参数的冗余性和网络结构的冗余性精简模型,在不影响任务完成度的情况下,得到参数量更少、结构更精简的模型。被压缩后的模型计算资源需求和内存需求更小,相比原始模型能够...

https://blog.csdn.net/shentanyue/article/details/83508497 https://blog.csdn.net/shentanyue/article/details/83539227 https://blog.csdn.net/shentanyue/article/details/83539359 ...

Draco 是用于网格压缩的 glTF 扩展,以及由 Google 开发的开源库,用于压缩和解压缩 3D 网格以显着减小 3D 内容的大小。它压缩顶点位置、法线、颜色、纹理坐标和任何其他通用顶点属性,从而提高通过 Web 传输 3D ...

推荐文章

- 大数据和云计算哪个更简单,易学,前景比较好?_大数据和云计算哪个好-程序员宅基地

- python操作剪贴板错误提示:pywintypes.error: (1418, 'GetClipboardData',线程没有打开的剪贴板)...-程序员宅基地

- IOS知识点大集合_ios /xmlib.framework/headers/xmmanager.h:66:32: ex-程序员宅基地

- Android Studio —— 界面切换_android studio 左右滑动切换页面-程序员宅基地

- 数据结构(3):java使用数组模拟堆栈-程序员宅基地

- Understand_6.5.1175::New Project Wizard_understand 6.5.1176-程序员宅基地

- 从零开始带你成为MySQL实战优化高手学习笔记(二) Innodb中Buffer Pool的相关知识_mysql_global_status_innodb_buffer_pool_reads-程序员宅基地

- 美化上传文件框(上传图片框)_文件上传框很丑-程序员宅基地

- js简单表格操作_"var str = '<table border=\"5px\"><tr><td>序号</td><-程序员宅基地

- Power BI销售数据分析_powerbi汇总销售人员业绩包括无销售记录的人-程序员宅基地