”seq2seq“ 的搜索结果

一 什么是Seq2Seq? 所谓Seq2Seq(Sequence to Sequence), 就是一种能够根据给定的序列,通过特定的方法生成另一个序列的方法。它被提出于2014年,最早由两篇文章独立地阐述了它主要思想,分别是Google Brain团队的...

matlab代码左移神经机器翻译(seq2seq)教程 作者:Thang Luong,Eugene Brevdo,赵瑞(,) 此版本的教程要求。 要使用稳定的TensorFlow版本,请考虑其他分支,例如。 如果您使用此代码库进行研究,请引用。 介绍 ...

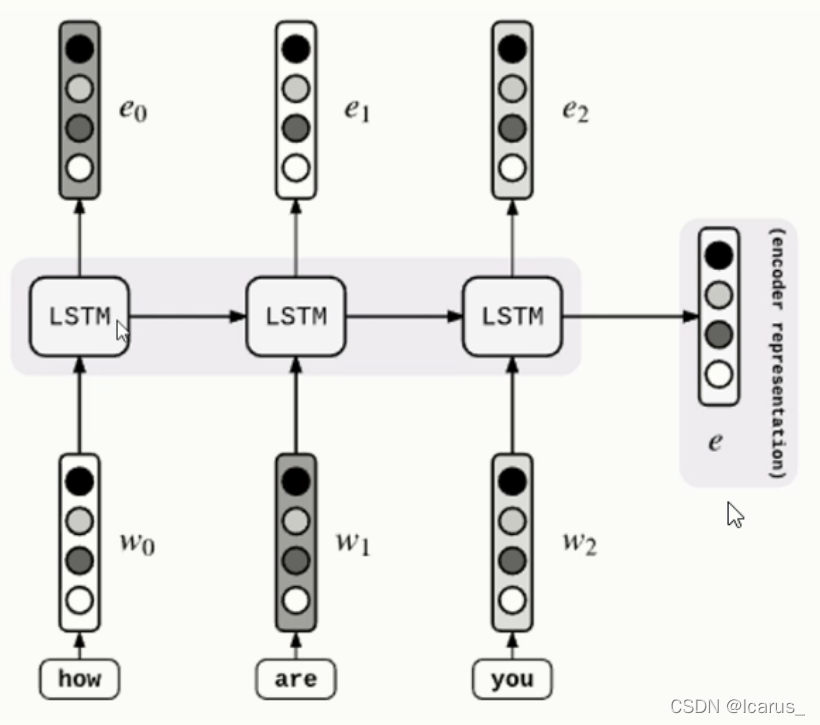

Seq2Seq 属于 Encoder-Decoder 结构。基本思想就是利用两个 RNN,一个 RNN 作为 Encoder,另一个 RNN 作为 Decoder。Encoder 负责将输入序列压缩成指定长度的向量,这个向量就可以看成是这个序列的语义,这个过程...

机器翻译(Machine Translation)是NLP领域中一个重点研究的话题。随着深度学习或者神经网络的发展,现在神经机器翻译(Neuralmachine ...要了解神经机器翻译,Sequence2sequence模型(简称Seq2seq)是第一步 .........

Seq2Seq /注意 WaveNet 变压器/变压器 快速开始 from deepseries . models import Wave2Wave , RNN2RNN from deepseries . train import Learner from deepseries . data import Value , create_seq2seq_data_...

基于seq2seq做一个机器翻译 我们将使用PyTorch和TorchText构建一个机器学习模型,从一个序列到另一个序列。 这将在德语到英语的翻译中完成

mbart预训练模型的使用

基于seq2seq模型的风功率预测.zip

在李纪为博士的毕业论文中提到,基于生成的闲聊机器人中,seq2seq是一种很常见的技术。例如,在法语-英语翻译中,预测的当前英语单词不仅取决于所有前面的已翻译的英语单词,还取决于原始的法语输入;另一个例子,...

什么是seq2seq Seq2Seq模型是输出的长度不确定时采用的模型,这种情况一般是在机器翻译的任务中出现,将一句中文翻译成英文,那么这句英文的长度有可能会比中文短,也有可能会比中文长,所以输出的长度就不确定了。...

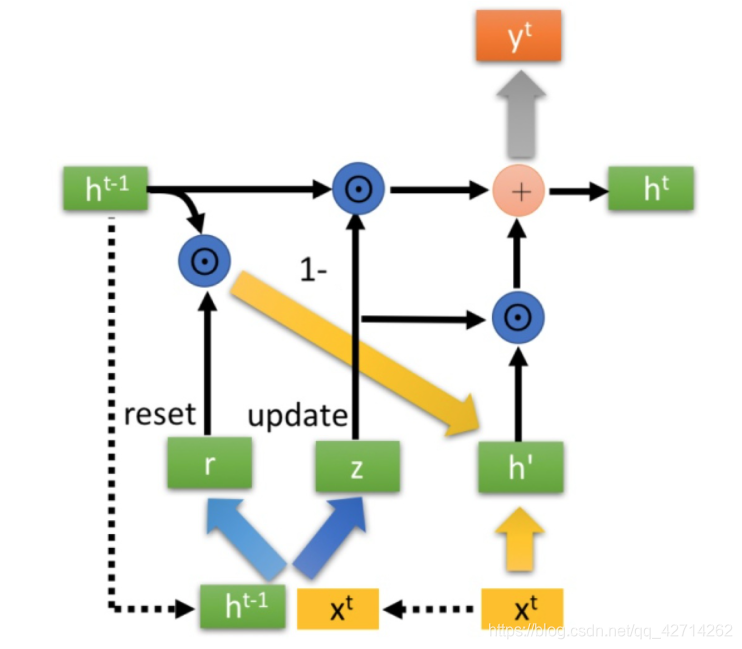

这是一个基于seq2seq模型的聊天系统,使用LSTM/GRU+注意力机制。使用开源框架pytorch。 环境 python 3.6 pytorch 0.4 其他python库

首先seq2seq模型可以用来处理许多NLP相关任务,这里介绍加入attention机制的意义以及算法 对于普通Seq2Seq模型,Encoder本身是一个RNN模型,下面的x1,x2,x3,...,xm是embedding过的词向量,对应的h1,h2,3,...,hm是...

基于seq2seq模型的的字典发音预测.zip

TensorFlow新闻TensorFlow CNN模型项目: : TensorFlow LSTM模型项目: : TensorFlow Seq2Seq模型项目: : 数据Twitter数据集:培养您需要添加模型文件夹以保存模型。 Train_Model.py跑Run_model.py工具idx2w,w2idx...

seq2seq + attention 详解 作者:xy_free \qquad 时间:2018.05.21 1. seq2seq模型 seq2seq模型最早可追溯到2014年的两篇paper [1, 2],主要用于机器翻译任务(MT)。seq2seq本质上是一种encoder-decoder框架,以...

seq2seq文本翻译数据集

标签: ml

seq2seq文本翻译数据集

Seq2seq与attention图解1

推荐文章

- Android 编译so文件 MP4V2_android下编译mp4v2-程序员宅基地

- 通讯录Contact_02_contact文件内容-程序员宅基地

- Qt笔记(四十二)之QZXing的编译 配置 使用_qzxingfilterrunnable error:-程序员宅基地

- 关于画图软件Dia打开程序始终为英文界面的问题-程序员宅基地

- OpenCV从入门到精通实战(二)——文档OCR识别(tesseract)-程序员宅基地

- 详解avcodec_receive_packet 11_avcodec_receive_packet eagain-程序员宅基地

- OpenGL SuperBible 7th源码编译记录_superbible7-media github-程序员宅基地

- Wireshark简单使用-程序员宅基地

- MXNet 粗糙的使用指南_iou loss mxnet-程序员宅基地

- iOS对ipa包进行代码混淆《二》 ---代码混淆_ipa包混淆-程序员宅基地