map的使用范围就是需要对的那个数据进行处理,并且每次返回一个数据的时候,map就比较方便了。在实际生产中,不可能让我们完成这么简单的操作就行了,所以我们需要更复杂的操作,而reduce就是满足这个条件,它可以让...

”flink案例“ 的搜索结果

Flink案例源码和数据集.rar

Apache Flink 案例集(2022版).pdf

Flink案例实战.pdf

标签: flink

Flink

本文档总结了国内各个互联网巨头使用flink的案例,有美团,唯品会,滴滴,360等,如何实现对flink的各种应用,同时里面也包含对flink使用的总结。

Flink案例:向Kafka生产并消费数据程序1.1场景说明适用版本FusionInsight HD V100R002C70、FusionInsight HD V100R002C80。场景说明假定某个Flink业务每秒就会收到1个消息记录。基于某些业务要求,开发的Flink应用...

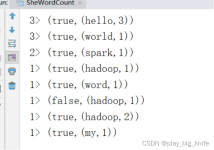

一、java版flink-wordcount-离线计算版 1.1maven构建flink,加入依赖 <!-- flink包依赖配置-start --> <dependency> <groupId>org.apache.flink</groupId> <artifactId>flink-java...

Flink 1.1.0 版本已经在官方发布了,官方博客于 2016-08-08 更新了 Flink 1.1.0 的变动。在这 Flink 版本的发布,添加了 SQL 语法这一特性。这对于业务场景复杂,依赖于 SQL 来分析统计数据,算得上是一个不错的...

Flink 批数据处理案例2. Flink流式数据处理案例3. Flink批和流案例总结数据源分为有界和无界之分,有界数据源可以编写批处理程序,无界数据源可以编写流式程序。DataSet API用于批处理,DataStream API用于流式处理...

Flink入门案例程序(中华石杉的课堂代码)代码分功能打包,清晰简单易懂,适合对flink有些功能函数不熟悉的人群

Flink java 入门项目。包括Flink java 开发环境搭建,基本项目结构等。

3.统计访问量 需要reduceFunction 或者aggregateFunction还是process。reduce的话要变成tuple 其余的aggere和process都可以。注意 我们要的结果肯定是url1->10 url2->15。需求:每隔10s统计每个url的访问量。...

Flink案例——kafka、MySQL source 一、kafka source flink和kafka的连接是十分友好的,毕竟是做流式处理的吧。 首先依赖 <dependency> <groupId>org.apache.flink</groupId> <artifactId>...

基于Flink流处理的动态实时超大规模用户行为分析 https://zhuanlan.zhihu.com/p/31548501 基于Flink流处理的动态实时超大规模用户行为分析 https://zhuanlan.zhihu.com/p/31460293 ...

在Hudi和Flink的集成案例中,我们可以使用Flink作为流处理引擎,实现实时数据的读取和写入。具体步骤如下: 首先,我们需要将输入数据源和输出数据源与Flink进行集成。Flink可以读取来自不同数据源的数据,例如...

1.概述 Flink 1.1.0 版本已经在官方发布了,官方博客于 2016-08-08 更新了 Flink ...加上之前有同学和朋友邮件中提到,Flink 官方给的示例运行有困难,能否整合一下 Flink 的案例。笔者通过本篇博客来解答一下...

参考官方网址: ...pom ` org.apache.flink flink-walkthrough-datastream-scala 1.13.1 <!-- https://mvnrepository.com/artifact/org.apache.flink/flink-walkthrough-common

flink学习教程,flink学习案例

1、实战案例1-数据清洗 学习要点: 1、双流操作CoFlatMap(双流操作包括cogroup,join和coflatmap) CoFlatMapFunction简单理解就是当stream1数据到来时,会调用flatMap1方法,stream2收到数据之时,会调用...

推荐文章

- 用好ASP.NET 2.0的URL映射-程序员宅基地

- C语言等级考试是把题目删了,历年全国计算机的等级考试二级C语言上机考试地训练题目库及答案详解(72页)-原创力文档...-程序员宅基地

- Microsoft Office显示正在更新无法打开的问题_正在更新microsoft 365和office-程序员宅基地

- 非常好的Ansible入门教程(超简单)-程序员宅基地

- 【Gradle-8】Gradle插件开发指南-程序员宅基地

- 使用PL/SQL Developer软件解锁_plsqldev表格锁怎么打开-程序员宅基地

- 【Windows Server 2019】Web服务 IIS 配置与管理——配置 IIS 进阶版 Ⅳ_iis默认路径-程序员宅基地

- 网络中的各层协议_发送消息时各层协议-程序员宅基地

- UCRT: VC 2015 Universal CRT, by Microsoft_vc15rt-程序员宅基地

- 关于EntityFramework 7 开发学习_entiry framework 7 书籍-程序员宅基地