hive(一)hive的安装与基本配置_hive安装与配置详解-程序员宅基地

技术标签: hive

目录

一、前提:

安装hive所需要的虚拟机环境为虚拟机安装有Hadoop并且集群成功,同时Hadoop需要在启动状态下,同时需要安装有mysql。不需要有zookeeper和HA,由于HA中含有大量进程,启动会占用很多资源,建议不要有HA

二、安装步骤:

1、上传jar包至/usr/local/soft

将hive-3.1.2上传到虚拟机中的/usr/local/soft目录下

2、解压并重命名

tar -zxvf apache-hive-3.1.2-bin.tar.gz

# 重命名

mv apache-hive-3.1.2-bin hive-3.1.2/

3、配置环境变量

vim /etc/profile

#增加以下内容:

# HIVE_HOME

export HIVE_HOME=/usr/local/soft/hive-3.1.2/

export PATH=$PATH:$HIVE_HOME/bin

#保存退出 source 使其生效

source /etc/profile

三、配置HIVE文件

1、配置hive-env.sh

cd $HIVE_HOME/conf

# 复制命令

cp hive-env.sh.template hive-env.sh# 编辑

vim hive-env.sh# 增加如下内容

# Set HADOOP_HOME to point to a specific hadoop install directory

HADOOP_HOME=/usr/local/soft/hadoop-2.7.6# Hive Configuration Directory can be controlled by:

export HIVE_CONF_DIR=/usr/local/soft/hive-3.1.2/conf

2、配置hive-site.xml

上传hive-site.xml到conf目录:

hive-site.xml文件内容:

<configuration>

<property>

<!-- 查询数据时 显示出列的名字 -->

<name>hive.cli.print.header</name>

<value>true</value>

</property>

<property>

<!-- 在命令行中显示当前所使用的数据库 -->

<name>hive.cli.print.current.db</name>

<value>true</value>

</property>

<property>

<!-- 默认数据仓库存储的位置,该位置为HDFS上的路径 -->

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

</property>

<!-- 8.x -->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true&useSSL=false&serverTimezone=GMT</value>

</property>

<!-- 8.x -->

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

<!-- hiveserver2服务的端口号以及绑定的主机名 -->

<property>

<name>hive.server2.thrift.port</name>

<value>10000</value>

</property>

<property>

<name>hive.server2.thrift.bind.host</name>

<value>master</value>

</property>

</configuration>3、配置日志

# 创建日志目录

cd $HIVE_HOME

mkdir log# 设置日志配置

cd confcp hive-log4j2.properties.template hive-log4j2.properties

vim hive-log4j2.properties

# 修改以下内容:

property.hive.log.dir = /usr/local/soft/hive-3.1.2/log

4、修改默认配置文件

cp hive-default.xml.template hive-default.xml

5、上传MySQL连接jar包

上传 mysql-connector-java-5.1.37.jar 至 /usr/local/soft/hive/lib目录中

四、修改MySQL编码

修改mysql编码为UTF-8:

1、 编辑配置文件

vim /etc/my.cnf

2、加入以下内容:

[client]

default-character-set = utf8mb4

[mysqld]

character-set-server = utf8mb4

collation-server = utf8mb4_general_ci

3、 重启mysql

systemctl restart mysqld

五、初始化HIVE

schematool -dbType mysql -initSchema

六、进入hive

输入命令:hive

七、后续配置

修改mysql元数据库hive,让其hive支持utf-8编码以支持中文

登录mysql:

mysql -u root -p123456

切换到hive数据库:

use hive;

1).修改字段注释字符集

alter table COLUMNS_V2 modify column COMMENT varchar(256) character set utf8;

2).修改表注释字符集

alter table TABLE_PARAMS modify column PARAM_VALUE varchar(4000) character set utf8;

3).修改分区表参数,以支持分区键能够用中文表示

alter table PARTITION_PARAMS modify column PARAM_VALUE varchar(4000) character set utf8;

alter table PARTITION_KEYS modify column PKEY_COMMENT varchar(4000) character set utf8;

4).修改索引注解(可选)

alter table INDEX_PARAMS modify column PARAM_VALUE varchar(4000) character set utf8;

5).修改库注释字符集

alter table DBS modify column DESC varchar(4000) character set utf8;

八、测试hive

启动hive,直接输入命令:hive

在hive中创建filetest数据库

命令: create database filetest;

切换filetest数据库:use filetest;

hive中的几种存储格式

TextFile格式:文本格式

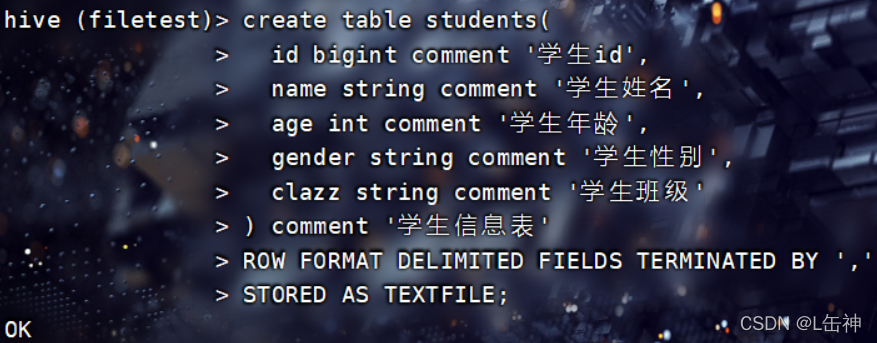

以TextFile格式创建students表:

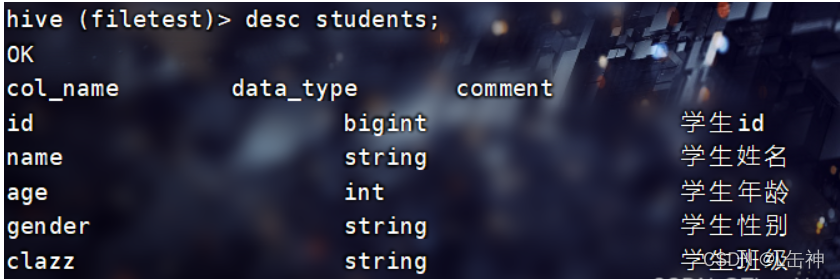

使用命令:desc students查看students表的各个字段:

在hive根目录下创建一个文件夹data用于存放本地文件,将本地中的一个文本文件上传到hive根目录下的data中

向表中插入数据:

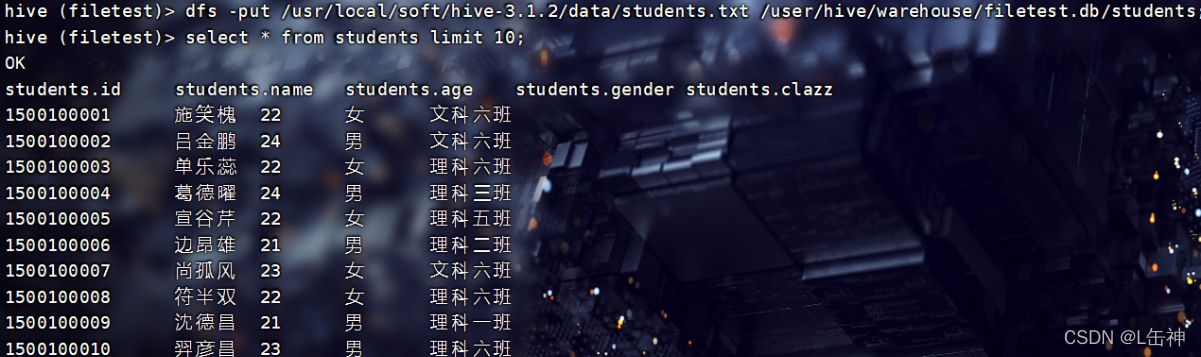

1、通过input命令将该data中的文本文件上传到hdfs中所创建的该表中,实现向该表中插入数据

在hive中可以使用hdfs中的命令:

查询结果:

2、通过普通的格式对表中进行插入数据

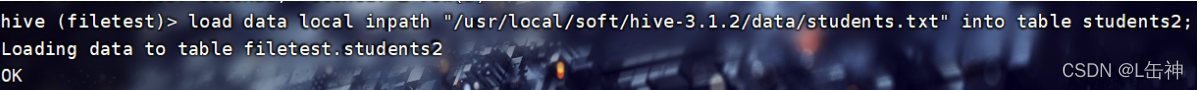

创建一个新的表stduents2,使用普通格式进行插入数据:

load data local inpath "/usr/local/soft/hive-3.1.2/data/students.txt" into table students2;

结果:

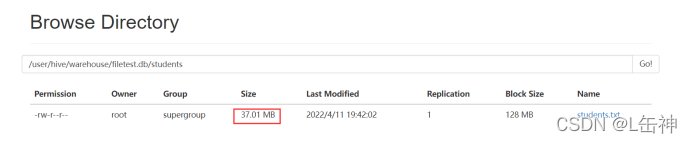

进入到hdfs中查看:发现两种插入方式对数据大小没有变化,都是37M:

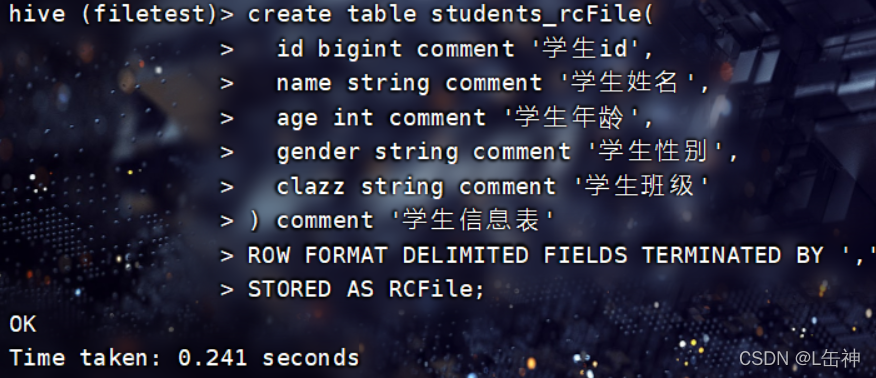

RCFile:

Hadoop中第一个列文件格式

RCFile通常写操作较慢,具有很好的压缩和快速查询功能。

创建RCFile格式的表:

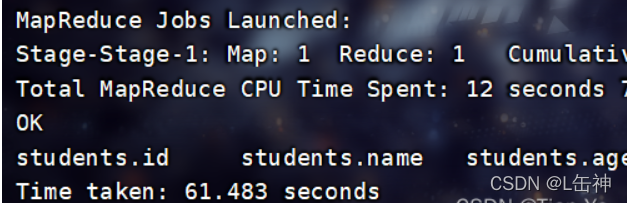

插入数据:

使用命令:

insert into table students_rcFile select * from students;

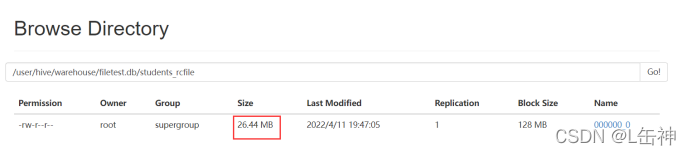

插入完成后,查看数据大小:为26.44M

ORCFile:

Hadoop0.11版本就存在的格式,不仅是一个列文件格式,而且有着很高的压缩比

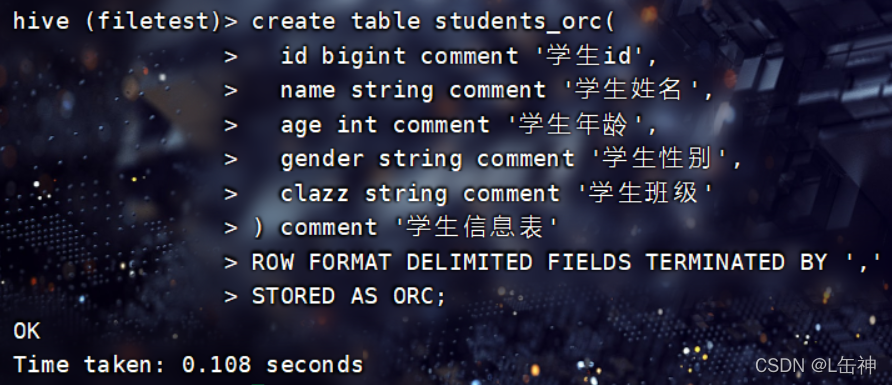

创建ORCFile格式的表:

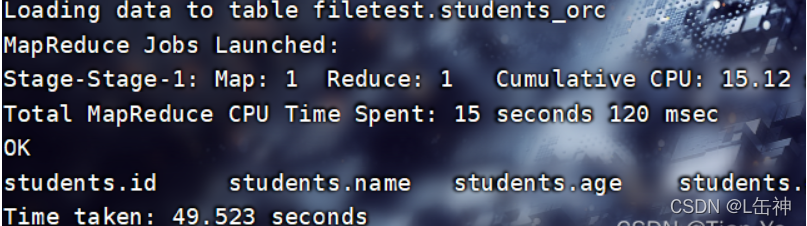

向表中插入数据:

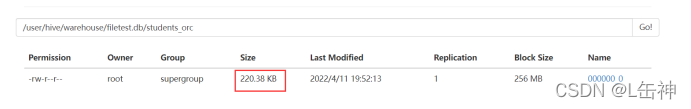

查看数据大小:被压缩为220.38KB

同时观察插入数据所用时间,ORCFile格式与RCFile格式插入数据相差时间不大

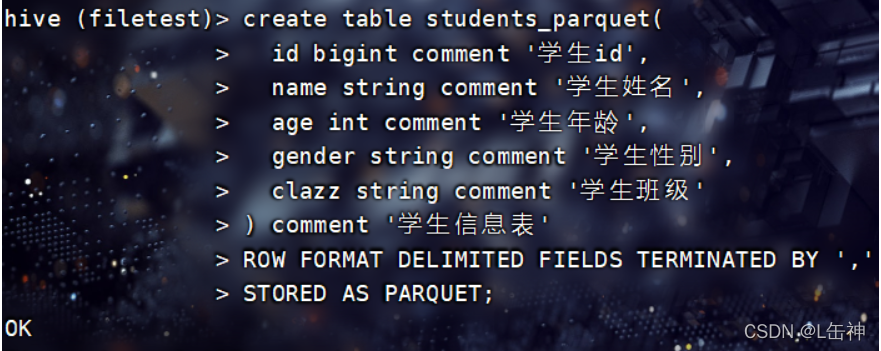

Parquet:

这是一种嵌套结构的存储格式,他与语言、平台无关

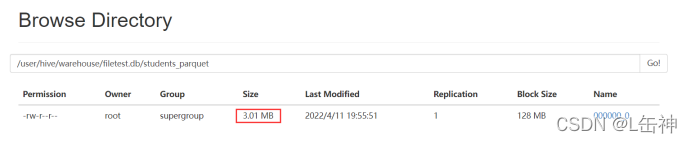

创建Parquet格式的表:

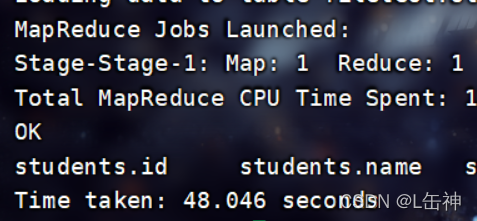

向表中插入数据:

insert into table students_parquet select * from students;

查看数据大小:为3M

同时发现该格式在插入数据时所花费的时间比ORC格式所花费的时间更少。

其他格式:

SEQUENCEFILE格式:这是一个Hadoop API提供的一种二进制文件格式,实际生产中不使用

AVRO:是一种支持数据密集型的二进制文件格式,他的格式更为紧凑

九、配置JDBC连接

Hive中有两种命令模式:CLi模式和JDBC模式

Cli模式就是Shell命令行

JDBC模式就是Hive中的Java,与使用传统数据库JDBC的方式类似

开启JDBC连接:

进入到/usr/local/soft/hive-3.1.2/bin目录下,在bin目录下有一个hiveserver2文件,通过该文件开启JDBC连接:

输入命令:hive --service hiveserver2开启JDBC连接

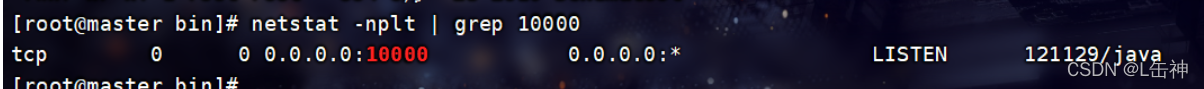

一般情况下当出现四个Hive Session时就说明JDBC连接被开启了,也可以通过命令查看是否开启:

进入到 /usr/local/soft/hive-3.1.2/bin目录下:

输入:netstat -nplt | grep 10000

该输入的端口号为hive-site.xml中的hiveserver2服务的端口号

报错:

若输入该命令报错:

Error: Could not open client transport with JDBC Uri: jdbc:hive2://master:10000:

Failed to open new session: java.lang.RuntimeException:

org.apache.hadoop.ipc.RemoteException(org.apache.hadoop.security.authorize.AuthorizationException):

User: root is not allowed to impersonate root (state=08S01,code=0)

解决办法:

先关闭Hadoop集群:stop-all.sh

再进入到Hadoop 中的core-site.xml中添加如下内容:

<property>

<name>fs.trash.interval</name>

<value>1440</value>

</property>

#以下是添加的内容:

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

</configuration>注意:这些内容需要添在加<configuration>...</configuration>中,否则无法生效

重新启动集群:start-all.sh

再次启动hiveserver2

hive --service hiveserver2

该过程较慢,需要等待

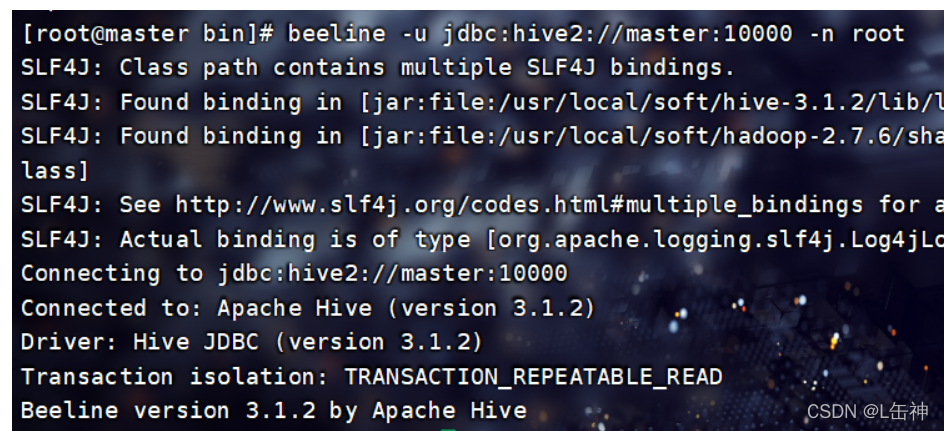

连接到JDBC

当启动JDBC连接后,会开启一个进程RunJar,使用jps命令就可查看

Hive 将元数据存储在数据库中(metastore),目前只支持 mysql、derby

连接到JDBC命令:

进入到 /usr/local/soft/hive-3.1.2/bin下,输入命令:

beeline -u jdbc:hive2://master:10000 -n root连接JDBC:

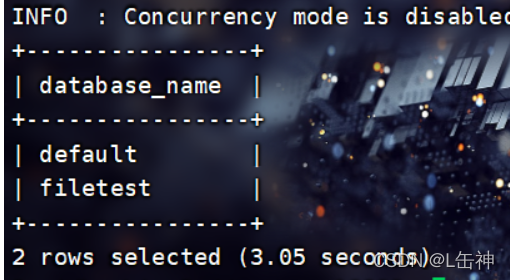

在JDBC中输入命令可以查看当前hive中的数据库:show databases;

可以发现他与hive的区别在于他使用了一个表格式将databases显示出来

Hive中metastore是hive元数据的集中存放地,这里使用的是MySQL

智能推荐

vue-cli(vue脚手架)超详细教程_vue cli模式教程-程序员宅基地

文章浏览阅读568次。目录前言1.安装vue-cli2.用vue-cli来构建项目3.启动项目4.vue-cli的webpack配置分析5.打包上线前言都说Vue2简单上手容易,的确,看了官方文档确实觉得上手很快,除了ES6语法和webpack的配置让你感到陌生,重要的是思路的变换,以前用jq随便拿全局变量和修改dom的锤子不能用了,vue只用关心数据本身,不用再频繁繁琐的操作dom,注册事件、监听事件、取消事件。。。。(确实很烦)。vue的官方文档还是不错的,由浅到深,如果不使用构建工具确实用的_vue cli模式教程

python中文件读写open file read write等操作函数_filereadwrite-程序员宅基地

文章浏览阅读2.4k次。1. 文件对象的操作使用open()或者file()函数打开文件。使用file.read()读取文件。使用file.readline()读取文件的一行相关信息。使用file.write()进行写入文件。使用file.writelines(seq)向文件写入字符串序列seq。使用file.close()关闭文件。使用file.tell()返回当前在文件中的位置。使用file.seek..._filereadwrite

Numpy一维数组-程序员宅基地

文章浏览阅读2.1k次。一维数组的实现pandas:Seriesnumpy:ndarray 2. ndarry和python list的比较相似: 通过位置访问元素,I[0] I[2:5] I[:3] I[2:] 循环:for item in l:xxx不同: python list元素可以任意类型组合,ndarray元素类型必须相同(不同时numpy会自动..._numpy一维数组

汇总onchange、onpropetrychange、和oninput事件的区别_onproperchange-程序员宅基地

文章浏览阅读280次。1、 onchange事件与 onpropertychange 事件的区别:onchange事件在内容改变(两次内容有可能还是相同的)且失去焦点时触发。onpropertychange事件却是实时触发,即每增加一个字符或者减少一个字符就会触发,通过js改变也会触发该事件,但是该事件是IE专有的。2、oninput 事件与onpropertychange 事件的区别:oninput事件是IE之外的大多浏览器支持的事件,在value改变时触发,实时的,即每增加一个或者删除一个字符就会触发,然_onproperchange

pdf转word4.0_java超大pdf转world-程序员宅基地

文章浏览阅读1.9k次。pdf转word4.0前言PDF转换WORD是用java语言编写,只需把PDF文件放置指定的目录下,然后运行java程序,即可实现了PDF文件转换word文件,轻松快捷。1、视频演示链接:https://pan.baidu.com/s/1snqOO1J 密码:n7rv2、源码下载 注意:需要本文源代码可加QQ490647751 回复关键字‘开通vip-pdf转w_java超大pdf转world

iOS混合开发支持横竖屏转换问题汇总_wkwebview怎么实现强制横屏-程序员宅基地

文章浏览阅读1.3k次。1、wkwebview支持横屏单页面支持旋转参考1、参考2、参考3# pragma mark 支持横竖屏幕转换- (void)willRotateToInterfaceOrientation:(UIInterfaceOrientation)toInterfaceOrientation duration:(NSTimeInterval)duration{ NSLog(@"UIViewController will rotate to Orientation: %ld", toInterface_wkwebview怎么实现强制横屏

随便推点

图像处理——matlab人脸识别(1)-程序员宅基地

文章浏览阅读2.1w次,点赞28次,收藏375次。目录一、前言二、相关程序(一)主函数(二)图库生成函数(三)图库图像命名函数(四)待识别图库生成函数(五)待识别图库命名函数(六)图像数据导入函数(七)PCA简单主成分分析函数(八)图像匹配函数三、识别效果一、前言近期,要做一个人脸识别的课题,于是在前人的基础上做了一些。对于图像处理我还属于初学阶段,在人脸识别算法上没有采用很高级的算法。参考的文章:利用MATLAB截取图片某个区域_蓝天萝卜-程序员宅基地Matlab实现人脸识别_王小壮的博_matlab人脸识别

二十三.激光和惯导LIO-SLAM框架学习之LIO-SAM项目工程代码介绍---基础知识_sc_lio_sam-程序员宅基地

文章浏览阅读3.3k次。专栏系列文章如下:一:Tixiao Shan最新力作LVI-SAM(Lio-SAM+Vins-Mono),基于视觉-激光-惯导里程计的SLAM框架,环境搭建和跑通过程_goldqiu的博客-程序员宅基地二.激光SLAM框架学习之A-LOAM框架---介绍及其演示_goldqiu的博客-程序员宅基地三.激光SLAM框架学习之A-LOAM框架---项目工程代码介绍---1.项目文件介绍(除主要源码部分)_goldqiu的博客-程序员宅基地四.激光SLAM框架学习之A-LOAM框架---项目工.._sc_lio_sam

android调用天地图,天地图嵌入到Android手机中-程序员宅基地

文章浏览阅读327次。该楼层疑似违规已被系统折叠隐藏此楼查看此楼3.2 使用步骤1) 将 API 文件 tiandituapi.jar 拷贝到工程根目录下,并在工程属性->JavaBuild Path->Libraries 中选择“Add External JARs”, tiandituapi.jar,确定后返回,这样您就可以在您的程序中使用 API 了。2) 需要在 Manifest 中添加如下访问权限..._android原生打开天地图

PMP第7章:成本基准易错习题和知识点汇总_什么过程输出成本基线-程序员宅基地

文章浏览阅读820次。PMP第7章:成本基准易错习题和知识点汇总1.成本基准是下列哪个过程的输出?A:规划成本管理B:估算成本C:制定预算正确答案D:控制成本答案解析: 成本基准是“制定预算“过程的输出。”正确答案:C以下哪项是估算成本过程的输入?A:工作分解结构B:成本基准C:合同D:资源日历答案解析: “工作分解结构属于范围基准,指明了项目全部可交付成果及其各组成部分之间的相互关系“,是估算成本过程的输入。正确答案:A3.通过项目状态报告,项目挣值(EV)为0.6,计划价值(PV)为0.1,通过_什么过程输出成本基线

python中意外缩进是什么意思_与python中的“意外缩进”怎么办?-程序员宅基地

文章浏览阅读74次。Python在行的开头使用空格来确定代码块的开始和结束时间。您可以获得的错误是:意外缩进。这行代码的开头比以前的空格多,但前面的不是子块的开头(例如if / while / for语句)。块中的所有代码行必须以完全相同的空格字符串开头。例如:>>>defa():...print"foo"...print"bar"IndentationError:unexpected indent当以交互方式运行p..._不匹配任何外部缩进级别

redis存opc_KEPServerEX6完整免费版-程序员宅基地

文章浏览阅读2.1k次。KEPServerEX6完整免费版是一款先进的连接平台,主要用于为您的应用程序提供单一来源的工业自动化数据,通过连接、管理、监视和控制不通的自动化设备和应用程序来实现工业数据。具有严谨的技术特征,支持多达250种以上的通讯协定,可连接到各种系统、装置和监控器。有需要的朋友可以来本站下载!KEPServerEX 6新功能1、通过配置 API 进行程序化修改利用基于 REST 的 API,用户能够通过..._kepserver有没有免费版