Kubernetes:从Cloud Provider到Cloud Controller Mananger全解析_uninitialized=true:noschedule-程序员宅基地

技术标签: 云原生 Cloud Controller Manager Cloud Provider Kubernetes

一、背景

1.1 基于Kubernetes的容器云

容器云最主要的功能帮助用户把应用以容器的形式在集群中跑起来。目前很多的容器云平台通过Docker及Kubernetes等技术提供应用运行平台,从而实现运维自动化、快速部署应用、弹性伸缩和动态调整应用环境资源,提高研发运营效率。

1.2 Cloud Provider与云厂商

为了更好的让Kubernetes在公有云平台上运行,提供容器云服务,云厂商需要实现自己的Cloud Provider,即实现cloudprovider.Interface(https://github.com/kubernetes/kubernetes/blob/master/pkg/cloudprovider/cloud.go)。

它是Kubernetes中开放给云厂商的通用接口,便于Kubernetes自动管理和利用云服务商提供的资源,这些资源包括虚拟机资源、负载均衡服务、弹性公网IP、存储服务等。

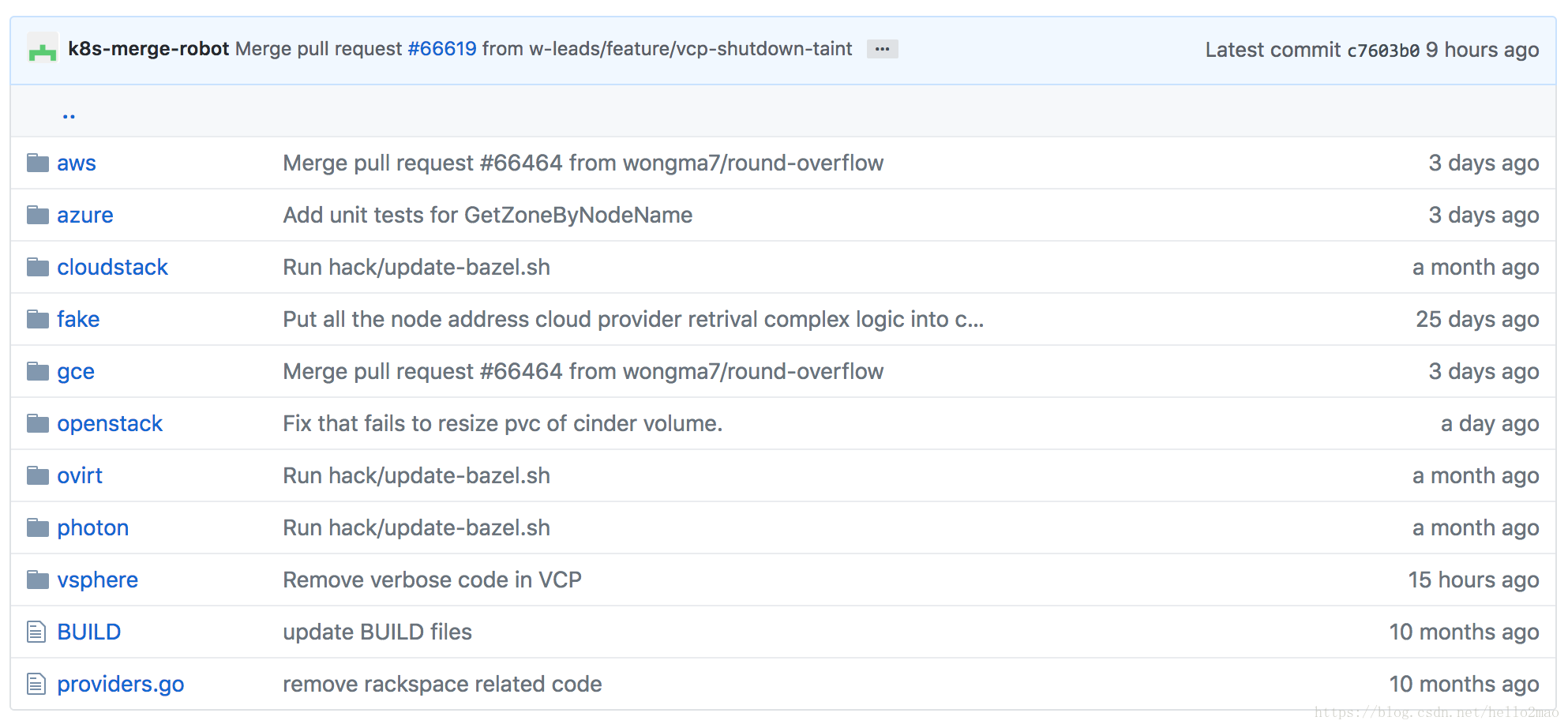

如下图所示,Kubernetes核心库内置了很多主流云厂商的实现,包括aws、gce、azure:

1.3 Cloud Provider的重构之路

但是,问题随之而来。

随着Kubernetes成为在私有云、公有云和混合云环境中大规模部署容器化应用的事实标准,越来越多的云厂商加入了进来,Cloud Provider的实现也越来越多,作为在Kubernetes核心库中的代码,这必将影响其快速的更新和迭代。

所以产生了把Cloud Provider移出Kubernetes核心库并进行重构的提案(Refactor Cloud Provider out of Kubernetes Core)。

在k8s v1.6,引入了Cloud Controller Manager(CCM),目的就是最终替代Cloud Provider。截止到最新的k8s v1.11,还是处于beta阶段。

二、Cloud Provider解析

2.1 Cloud Provider的作用

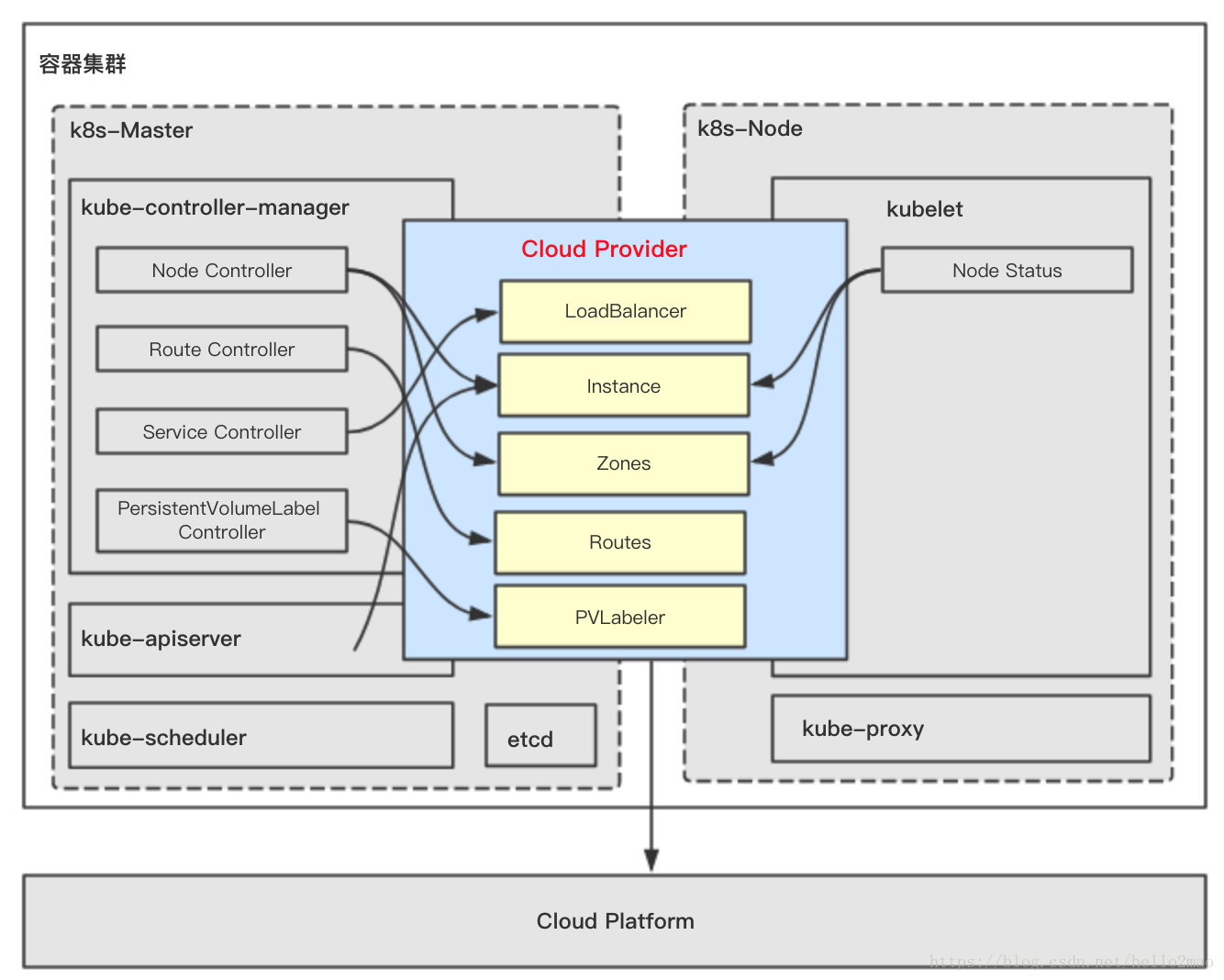

在k8s中有三个组件对Cloud Provider有依赖,分别是:

- kube-controller-manager

- kubelet

- kube-apiserver

这三个组件对Cloud Provider的依赖部分会最终编译进相应的二进制中,进一步的依赖关系如下图所示:

2.1.1 kube-controller-manager依赖Cloud Provider相关部分

kube-controller-manager对Cloud Provider的依赖分布在四个controller中。

2.1.1.1 Node Controller

Node Controller使用Cloud Provider来检查node是否已经在云上被删除了,如果Cloud Provider返回有node被删除了,那么Node Controller立马就会把此node从k8s中删除。

2.1.1.2 Route Controller

用来配置node的路由。

对于Kubernetes的容器网络,基本的原则是:每个pod都拥有一个独立的IP地址(IP per Pod),而且假定所有的pod都在一个可以直接连通的、扁平的网络空间中。而在云上,node的基础设施是由云厂商提供的,所以Route Controller需要调用Cloud Provider来配置云上node的底层路由从而实现Kubernetes的容器网络。

2.1.1.3 Service Controller

Service Controller维护了当前可用node的列表,同时负责创建、删除、更新类型是LoadBalancer的Service,从而使用云厂商额外提供的负载均衡服务、弹性公网IP等服务。

2.1.1.4 PersistentVolumeLabel Controller

PersistentVolumeLabel Controller使用Cloud Provider来创建、删除、挂载、卸载node上的卷,因为卷也是云厂商额外提供的云存储服务。

2.1.2 kubelet依赖Cloud Provider相关部分

kubelet中的Node Status使用Cloud Provider来获得node的信息。包括:

- nodename:运行kubelet的节点名字

- InstanceID, ProviderID, ExternalID, Zone Info:初始化kubelet的时候需要

- 周期性的同步node的IP

2.1.3 kube-apiserver依赖Cloud Provider相关部分

kube-apiserver使用Cloud Provider来给所有node派发SSH Keys。

2.2 Cloud Provider的设计

云厂商在实现自己的Cloud Provider时只需要实现cloudprovider.Interface即可,如下:

type Interface interface {

// 初始化一个k8s client,用于和kube-apiserver通讯

Initialize(clientBuilder controller.ControllerClientBuilder)

// 与负载均衡相关的接口

LoadBalancer() (LoadBalancer, bool)

// 与节点信息相关的接口

Instances() (Instances, bool)

// 与节点可用区相关的接口

Zones() (Zones, bool)

// 与集群相关的接口

Clusters() (Clusters, bool)

// 与路由相关的接口

Routes() (Routes, bool)

// cloud provider ID.

ProviderName() string

// ClusterID

HasClusterID() bool

}重点讲下两个比较重要的接口LoadBalancer()与Routes()。

2.2.1 LoadBalancer()的接口设计

LoadBalancer()接口用来为kube-controller-manager的Service Controller服务,接口说明如下:

type LoadBalancer interface {

// 根据clusterName和service返回是否存LoadBalancer,若存在则返回此LoadBalancer的状态信息,状态信息里包含此LoadBalancer的对外IP和一个可选的HostName

GetLoadBalancer(ctx context.Context, clusterName string, service *v1.Service) (status *v1.LoadBalancerStatus, exists bool, err error)

// 更新或者创建一个LoadBalancer,在用户创建一个type是LoadBalancer的Service时触发。

EnsureLoadBalancer(ctx context.Context, clusterName string, service *v1.Service, nodes []*v1.Node) (*v1.LoadBalancerStatus, error)

// 更新一个LoadBalancer,在Service信息发生改变或者集群信息发生改变时,例如集群新加入一个节点,那么需要更新下LoadBalancer,目的是为LoadBalancer更新下后端需要监听的新节点。

UpdateLoadBalancer(ctx context.Context, clusterName string, service *v1.Service, nodes []*v1.Node) error

// 删除一个LoadBalancer

EnsureLoadBalancerDeleted(ctx context.Context, clusterName string, service *v1.Service) error

}2.2.2 Routes()的接口设计

Routes()接口用来为kube-controller-manager的Route Controller服务,接口说明如下:

type Routes interface {

// 列举集群的路由规则

ListRoutes(ctx context.Context, clusterName string) ([]*Route, error)

// 为当前集群新建路由规则

CreateRoute(ctx context.Context, clusterName string, nameHint string, route *Route) error

// 删除路由规则

DeleteRoute(ctx context.Context, clusterName string, route *Route) error

}三、从Cloud Provider到Cloud Controller Manager

从k8s v1.6开始,k8s的编译产物中多了一个二进制:cloud-controller manager,它就是用来替代Cloud Provider的。

因为原先的Cloud Provider与mater中的组件kube-controller-manager、kube-apiserver以及node中的组件kubelet耦合很紧密,所以这三个组件也需要相应的进行重构。

3.1 kube-controller-manager的重构策略

kube-controller-manager中有四个controller与Cloud Provider相关,相应的重构策略如下:

- Route Controller

- 移入CCM,并在相应的controller loop中运行。

- Service Controller

- 移入CCM,并在相应的controller loop中运行。

- PersistentVolumeLabel Controller

- 移入CCM,并在相应的controller loop中运行。

- Node Controller

- 在CCM中增加新controller:Cloud Node Controller。

- Cloud Node Controller除了实现原来Node Controller的功能外,增加新功能:

- CIDR的管理

- 监控节点的状态

- 节点Pod的驱逐策略

3.2 kube-apiserver的重构策略

对于kube-apiserver使用Cloud Provider的两个功能:

- 分发SSH Keys

- 移入CCM

- 对于PV的Admission Controller

- 在kubelet中实现

3.3 kubelet的重构策略

kubelet需要增加一个新功能:在CCM还未初始化kubelet所在节点时,需标记此节点类似“NotReady”的状态,防止scheduler调度pod到此节点时产生一系列错误。此功能通过给节点加上如下Taints并在CCM初始化后删去此Taints实现:

node.cloudprovider.kubernetes.io/uninitialized=true:NoSchedule四、Cloud Controller Manager解析

4.1 Cloud Controller Manager架构

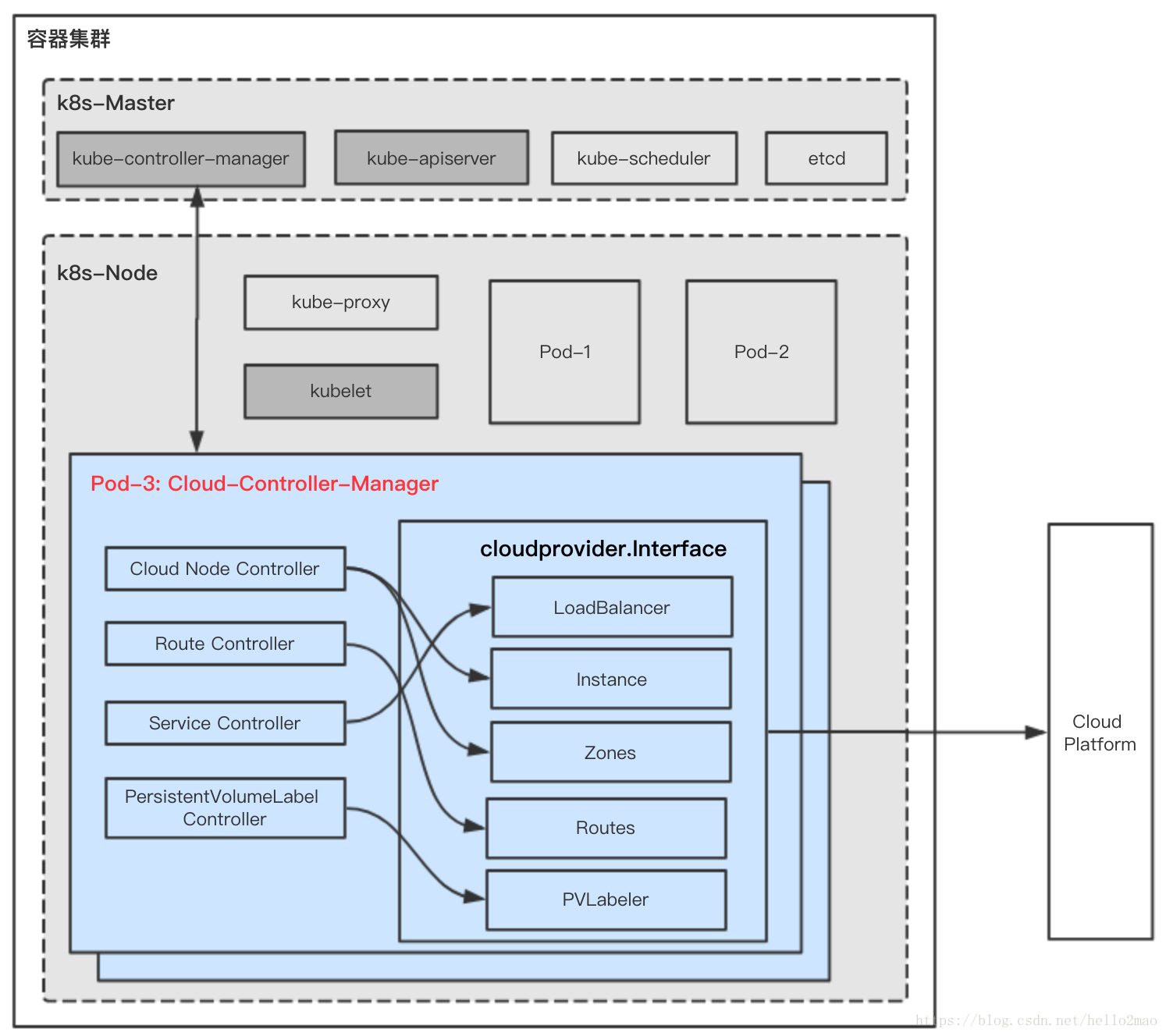

按照第三节所述进行重构后,新的模块Cloud Controller Manager将作为一个新的组件直接部署在集群内,如下图所示:

CCM组件内各小模块的功能与原先Cloud Provider的差不多,见第二节对Cloud Provider的解析。

对于云厂商来说,需要:

(1)实现cloudprovider.Interface接口的功能,这部分在Cloud Provider中已经都实现,直接迁移就行。

(2)实现自己的Cloud Controller Manager,并在部署k8s时,把CCM按要求部署在集群内,部署时的注意事项及部署参考实践见第五节。

4.2 Cloud Controller Manager实现举例

实现自己的CCM也比较简单,举例如下:

package main

import (

...

"k8s.io/kubernetes/cmd/cloud-controller-manager/app"

"k8s.io/kubernetes/cmd/cloud-controller-manager/app/options"

// (1)初始化原来Cloud Provider的相关逻辑,读取cloud配置、初始化云厂商的Clod SDK。

_ "k8s.io/cloud-provider-baiducloud/pkg/cloud-provider"

)

func main() {

goflag.CommandLine.Parse([]string{})

// (2) 初始化一个默认的CCM配置

s, _ := options.NewCloudControllerManagerOptions()

if err != nil {

glog.Fatalf("unable to initialize command options: %v", err)

}

// (3) CCM启动命令

cmd := &cobra.Command{

Use: "cloud-controller-manager",

Long: `The Cloud controller manager is a daemon that embeds the cloud specific control loops shipped with Kubernetes.`,

Run: func(cmd *cobra.Command, args []string) {

c, err := s.Config()

if err != nil {

fmt.Fprintf(os.Stderr, "%v\n", err)

os.Exit(1)

}

// (4) Run里会运行相关controller loops:CloudNode Controller、PersistentVolumeLabel Controller、Service Controller、Route Controller

if err := app.Run(c.Complete()); err != nil {

fmt.Fprintf(os.Stderr, "%v\n", err)

os.Exit(1)

}

},

}

s.AddFlags(cmd.Flags())

pflag.CommandLine.SetNormalizeFunc(flag.WordSepNormalizeFunc)

pflag.CommandLine.AddGoFlagSet(goflag.CommandLine)

logs.InitLogs()

defer logs.FlushLogs()

if err := c.Execute(); err != nil {

fmt.Fprintf(os.Stderr, "%v\n", err)

os.Exit(1)

}

}五、部署使用Cloud Controller Manager实践

5.1 总体要求

- 云厂商提供给CCM的API需要有认证鉴权机制,防止恶意行为。

- 因为CCM运行在集群内,所以需要RBAC规则去跟kube-apiserver通讯

- CCM为了高可用,可开启选主功能

5.2 k8s相关组件的启动配置变化

将Cloud Provider改为CCM后,相关组件启动的配置需要修改。

5.2.1 kube-controller-manager启动配置变化

不指定cloud-provider。

5.2.2 kube-apiserver启动配置变化

(1)不指定cloud-provider

(2)admission-control中删去PersistentVolumeLabel,因为CCM将接手PersistentVolumeLabel

(3)admission-control中增加Initializers

(4)runtime-config中增加admissionregistration.k8s.io/v1alpha1

5.2.3 kubelet启动配置变化

指定cloud-provider=external,告诉kubelet,在它开始调度工作前,需要被CCM初始化。(node会被打上 Taints:node.cloudprovider.kubernetes.io/uninitialized=true:NoSchedule)

5.3 启动CCM举例

5.3.1 启用initializers并添加InitializerConifguration

CCM为了给PV打标签需要:

(1)启用initializers(https://kubernetes.io/docs/reference/access-authn-authz/extensible-admission-controllers/#enable-initializers-alpha-feature)

(2)添加InitializerConifguration:persistent-volume-label-initializer-config.yaml如下:

admin/cloud/pvl-initializer-config.yaml

kind: InitializerConfiguration

apiVersion: admissionregistration.k8s.io/v1alpha1

metadata:

name: pvlabel.kubernetes.io

initializers:

- name: pvlabel.kubernetes.io

rules:

- apiGroups:

- ""

apiVersions:

- "*"

resources:

- persistentvolumes5.3.2 创建CCM的RBAC

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRole

metadata:

name: system:cloud-controller-manager

labels:

kubernetes.io/cluster-service: "true"

rules:

- apiGroups:

- ""

resources:

- nodes

verbs:

- '*'

- apiGroups:

- ""

resources:

- nodes/status

verbs:

- patch

- apiGroups:

- ""

resources:

- services

verbs:

- list

- watch

- patch

- apiGroups:

- ""

resources:

- services/status

verbs:

- update

- apiGroups:

- ""

resources:

- events

verbs:

- create

- patch

- update

# For leader election

- apiGroups:

- ""

resources:

- endpoints

verbs:

- create

- apiGroups:

- ""

resources:

- endpoints

resourceNames:

- "cloud-controller-manager"

verbs:

- get

- list

- watch

- update

- apiGroups:

- ""

resources:

- configmaps

verbs:

- create

- apiGroups:

- ""

resources:

- configmaps

resourceNames:

- "cloud-controller-manager"

verbs:

- get

- update

- apiGroups:

- ""

resources:

- serviceaccounts

verbs:

- create

- apiGroups:

- ""

resources:

- secrets

verbs:

- get

- list

# For the PVL

- apiGroups:

- ""

resources:

- persistentvolumes

verbs:

- list

- watch

- patch

---

kind: ClusterRoleBinding

apiVersion: rbac.authorization.k8s.io/v1

metadata:

name: xxx-cloud-controller-manager

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: system:cloud-controller-manager

subjects:

- kind: ServiceAccount

name: cloud-controller-manager

namespace: kube-system5.3.3 启动CCM

可以通过DaemonSet或者Deployment的方式启动CCM:

---

apiVersion: v1

kind: ServiceAccount

metadata:

name: cloud-controller-manager

namespace: kube-system

---

apiVersion: extensions/v1beta1

kind: DaemonSet

metadata:

name: xxx-cloud-controller-manager

namespace: kube-system

labels:

k8s-app: xxx-cloud-controller-manager

spec:

selector:

matchLabels:

k8s-app: xxx-cloud-controller-manager

updateStrategy:

type: RollingUpdate

template:

metadata:

labels:

k8s-app: xxx-cloud-controller-manager

spec:

hostNetwork: true

nodeSelector:

node-role.kubernetes.io/master: ""

tolerations:

- key: node.cloudprovider.kubernetes.io/uninitialized

value: "true"

effect: NoSchedule

- key: node-role.kubernetes.io/master

operator: Exists

effect: NoSchedule

serviceAccountName: cloud-controller-manager

containers:

- name: cloud-controller-manager

image: xxx-cloud-controller-manager:v1.0.0

args:

- --cloud-config=/path/to/cloud-config.yaml

- --cloud-provider=xxx

- -v=4

volumeMounts:

- name: cfg

mountPath: /etc/xxx

readOnly: true

- name: kubernetes

mountPath: /etc/kubernetes

readOnly: true

volumes:

- name: cfg

secret:

secretName: xxx-cloud-controller-manager

- name: kubernetes

hostPath:

path: /etc/kubernetes六、参考

智能推荐

使用UmcFramework和unimrcpclient.xml连接多个SIP设置的配置指南及C代码示例

在多媒体通信领域,MRCP(Media Resource Control Protocol)协议被广泛用于控制语音识别和合成等媒体资源。UniMRCP是一个开源的MRCP实现,提供了客户端和服务端的库。UmcFramework是一个基于UniMRCP客户端库的示例应用程序框架,它帮助开发者快速集成和测试MRCP客户端功能。本文将详细介绍如何使用UmcFramework和unimrcpclient.xml配置文件连接到多个SIP设置,以及如何用C代码进行示例说明。

java.net.ProtocolException: Server redirected too many times (20)-程序员宅基地

文章浏览阅读3k次。报错:java.net.ProtocolException: Server redirected too many times (20)1.没有检查到cookie,一直循环重定向。解决:CookieHandler.setDefault(new CookieManager(null, CookiePolicy.ACCEPT_ALL));URL url = new URL(url); ..._java.net.protocolexception: server redirected too many times (20)

springboot启动报错 Failed to scan *****/derbyLocale_ja_JP.jar from classloader hierarchy_failed to scan from classloader hierarchy-程序员宅基地

文章浏览阅读4.1k次。问题这是部分报错信息2019-07-11 14:03:34.283 WARN [restartedMain][DirectJDKLog.java:175] - Failed to scan [file:/D:/repo/org/apache/derby/derby/10.14.2.0/derbyLocale_ja_JP.jar] from classloader hierarchyjava...._failed to scan from classloader hierarchy

MATLAB-ones函数_matlab中ones函数-程序员宅基地

文章浏览阅读2.8k次,点赞3次,收藏7次。在MATLAB中,ones函数用于创建一个指定大小的由1组成的矩阵或数组。_matlab中ones函数

解决PS等软件出现应用程序无法正常启动(0xc000007b)_photoshop应用程序无法正常启动0xc000007b。请单击“确认”关闭应用程序。-程序员宅基地

文章浏览阅读3.9w次,点赞2次,收藏9次。 在使用电脑办公过程中,安装应用程序时难免遇到无法安装或者无法正常启动的问题,这对我们使用电脑带来了诸多不便。那遇到应用程序无法正常启动的问题要如何解决呢?相信大家肯定都是十分疑问的,每次都是只能忍痛重新安装软件。今天,小编就和大家探讨下应用程序无法正常启动的解决方法,帮助大家排忧解难。0xc000007b电脑图解1 第一种方案:SFC检查系统完整性来尝试修复丢失文件 1、打开电脑搜索输入cmd.exe,选择以管理员身份运行,跳出提示框时选择继续。0xc000007b电脑图解2_photoshop应用程序无法正常启动0xc000007b。请单击“确认”关闭应用程序。

oracle介质恢复和实例恢复的异同-程序员宅基地

文章浏览阅读396次。1、概念 REDO LOG是Oracle为确保已经提交的事务不会丢失而建立的一个机制。实际上REDO LOG的存在是为两种场景准备的:实例恢复(INSTANCE RECOVERY);介质恢复(MEDIA RECOVERY)。 实例恢复的目的是在数据库发生故障时,确保BUFFER CACHE中的数据不会丢失,不会造成数据库的..._oracle 实例恢复和介质恢复

随便推点

轻松搭建CAS 5.x系列(5)-增加密码找回和密码修改功能-程序员宅基地

文章浏览阅读418次。概述说明CAS内置了密码找回和密码修改的功能; 密码找回功能是,系统会吧密码重置的连接通过邮件或短信方式发送给用户,用户点击链接后就可以重置密码,cas还支持预留密码重置的问题,只有回答对了,才可以重置密码;系统可配置密码重置后,是否自动登录; 密码修改功能是,用户登录后输入新密码即可完成密码修改。安装步骤`1. 首先,搭建好cas sso server您需要按..._修改cas默认用户密码

springcloud(七) feign + Hystrix 整合 、-程序员宅基地

文章浏览阅读141次。之前几章演示的熔断,降级 都是 RestTemplate + Ribbon 和RestTemplate + Hystrix ,但是在实际开发并不是这样,实际开发中都是 Feign 远程接口调用。Feign + Hystrix 演示: eruka(略)order 服务工程: pom.xml<?xml version="1.0" encoding="U..._this is order 服务工程

YOLOv7如何提高目标检测的速度和精度,基于优化算法提高目标检测速度-程序员宅基地

文章浏览阅读3.4k次,点赞35次,收藏43次。学习率是影响目标检测精度和速度的重要因素之一。合适的学习率调度策略可以加速模型的收敛和提高模型的精度。在YOLOv7算法中,可以使用基于余弦函数的学习率调度策略(Cosine Annealing Learning Rate Schedule)来调整学习率。

linux中进程退出函数:exit()和_exit()的区别_linux结束进程可以用哪些函数,它们之间有何区别?-程序员宅基地

文章浏览阅读4k次,点赞4次,收藏9次。 linux中进程退出函数:exit()和_exit()的区别(1)_exit()执行后立即返回给内核,而exit()要先执行一些清除操作,然后将控制权交给内核。(2)调用_exit函数时,其会关闭进程所有的文件描述符,清理内存以及其他一些内核清理函数,但不会刷新流(stdin, stdout, stderr ...). exit函数是在_exit..._linux结束进程可以用哪些函数,它们之间有何区别?

sqlserver55555_sqlserver把小数点后面多余的0去掉-程序员宅基地

文章浏览阅读134次。select 5000/10000.0 --想变成0.5select 5500/10000.0 --想变成0.55select 5550/10000.0 --想变成0.555select 5555/10000.0 --想变成0.5555其结果分别为:0.5000000 0.5500000 0.5550000 0.5555000一、如果想去掉数字5后面多余的0 ,需要转化一下:selec..._sql server 去小数 0

Angular6 和 RXJS6 的一些改动_angular6,requestoptions改成了什么-程序员宅基地

文章浏览阅读3.1k次。例一:import { Injectable } from '@angular/core';import { Observable } from 'rxjs';import { User } from "./model/User";import { map } from 'rxjs/operators';import { Http, Response, Headers, RequestOp..._angular6,requestoptions改成了什么