个人信贷违约预测_个贷违约预测-程序员宅基地

技术标签: 数据分析

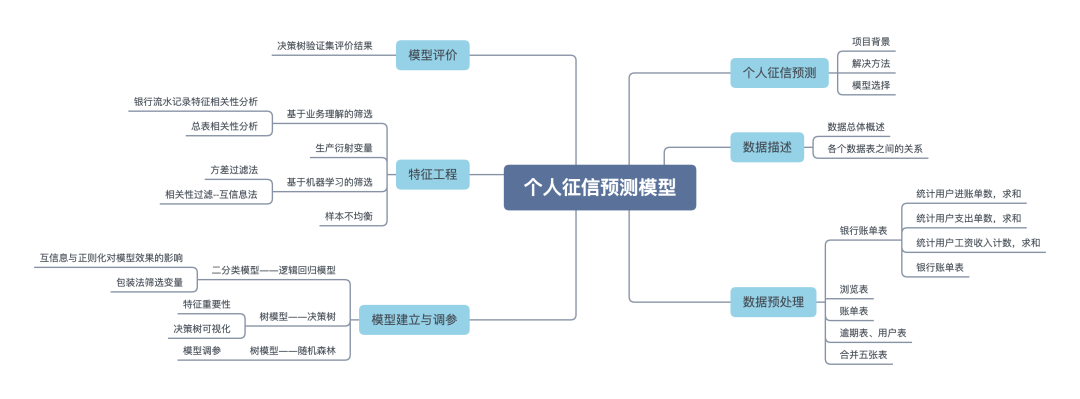

本次分享一个数据挖掘实战项目:个人信贷违约预测,此项目对于想要学习信贷风控模型的同学非常有帮助,数据和源码在文末。

项目背景

当今社会,个人信贷业务发展迅速,但同时也会暴露较高的信用风险。信息不对称在金融贷款领域突出,表现在过去时期借款一方对自身的财务状况、还款能力及还款意愿有着较为全面的掌握,而金融机构不能全面获知借款方的风险水平,或在相关信息的掌握上具有明显的滞后性。这种信息劣势,使得金融机构在贷款过程中可能由于风险评估与实际情况的偏离,产生资金损失,直接影响金融机构的利润水平。

而现今时间金融机构可以结合多方数据,提前对客户风险水平进行评估,并做出授信决策。

解决方法

运用分类算法预测违约

模型选择

单模型: 决策树、贝叶斯、SVM等

集成模型: 随机森林、梯度提升树等

评分卡模型: 逻辑回归

项目可输出: 评分卡

数据描述

数据总体概述

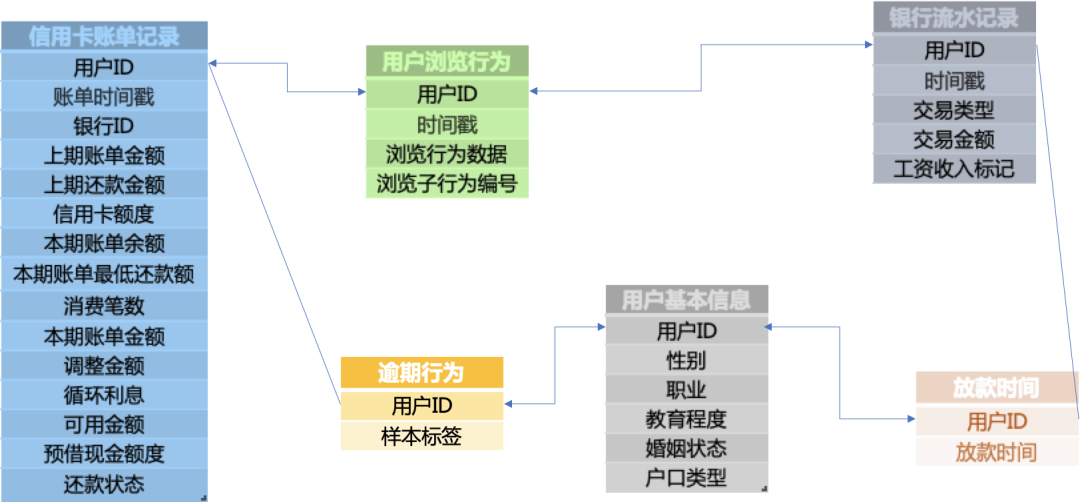

可用的训练数据包括用户的基本属性user_info.txt、银行流水记录bank_detail.txt、用户浏览行为browse_history.txt、信用卡账单记录bill_detail.txt、放款时间loan_time.txt,以及这些顾客是否发生逾期行为的记录overdue.txt。(注意:并非每一位用户都有非常完整的记录,如有些用户并没有信用卡账单记录,有些用户却没有银行流水记录。)

相应地,还有用于测试的用户的基本属性、银行流水、信用卡账单记录、浏览行为、放款时间等数据信息,以及待预测用户的id列表。

脱敏处理:(a) 隐藏了用户的id信息;(b) 将用户属性信息全部数字化;(c) 将时间戳和所有金额的值都做了函数变换。

(1)用户的基本属性user_info.txt。共6个字段,其中字段性别为0表示性别未知。

用户id,性别,职业,教育程度,婚姻状态,户口类型 6346,1,2,4,4,2

(2)银行流水记录bank_detail.txt。共5个字段,其中,第2个字段,时间戳为0表示时间未知;第3个字段,交易类型有两个值,1表示支出、0表示收入;第5个字段,工资收入标记为1时,表示工资收入。

用户id,时间戳,交易类型,交易金额,工资收入标记 6951,5894316387,0,13.756664,0

(3)用户浏览行为browse_history.txt。共4个字段。其中,第2个字段,时间戳为0表示时间未知。

用户id,时间戳,浏览行为数据,浏览子行为编号 34724,5926003545,172,1

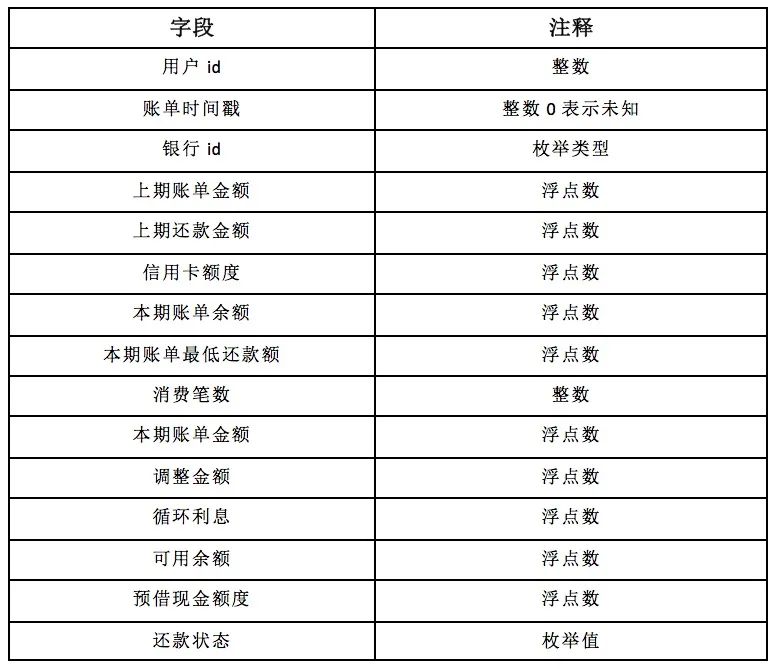

(4)信用卡账单记录bill_detail.txt。共15个字段,其中,第2个字段,时间戳为0表示时间未知。为方便浏览,字段以表格的形式给出。

(6)顾客是否发生逾期行为的记录overdue.txt。共2个字段。样本标签为1,表示逾期30天以上;样本标签为0,表示逾期10天以内。

注意:逾期10天~30天之内的用户,并不在此问题考虑的范围内。用于测试的用户,只提供id列表,文件名为testUsers.csv。

用户id,样本标签 1,1 2,0 3,1

各个数据表之间的关系

数据预处理

从表中数据得知并非每一位用户都有非常完整的记录,如有些用户并没有信用卡账单记录,有些用户却没有银行流水记录。

发现用户信息表,是否逾期表,放款时间表这三张表的id数目都是55,596,银行流水表为9,294,浏览信息表为47,330,信用卡账单表为53,174。通过用户id数得到并非每个用户都有银行流水记录、信用卡账单等信息,所以这里我们取6个表共同用户的记录筛选后组成完整的表。

我们要预测的测试集都是还没有放款的用户特征,所以训练数据这里我们也选取放款时间之前的特征,将存在时间戳的表与放款时间表进行交叉,只筛选此时间范围内的用户id。

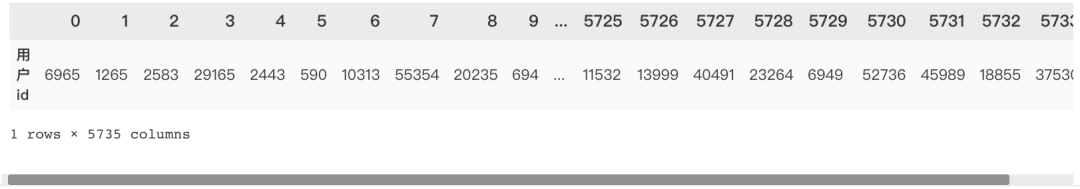

筛选出这6张表共有的用户id,得出5735个用户的记录是完整的。

user.T

银行账单表

bank_detail_select = pd.merge(left=df_bank_detail_train,

right=user,

how='inner',

on='用户id')

统计用户进账单数,求和

统计用户支出单数,求和

统计用户工资收入计数,求和

银行账单表

bank_train.head()

浏览表

先剔除5735以外的数据,再统计每个用户的浏览记录(count)

browse_train.head()

账单表

去掉了时间、银行id、还款状态这几个变量,按用户id分组后对每个字段均值化处理。

逾期表、用户表

合并五张表

将筛选后的五个表进行合并,得出25个字段

df_train=user_train.merge(bank_train)

df_train=df_train.merge(bill_train)

df_train=df_train.merge(browse_train)

df_train=df_train.merge(overdue_train)

df_train.head()

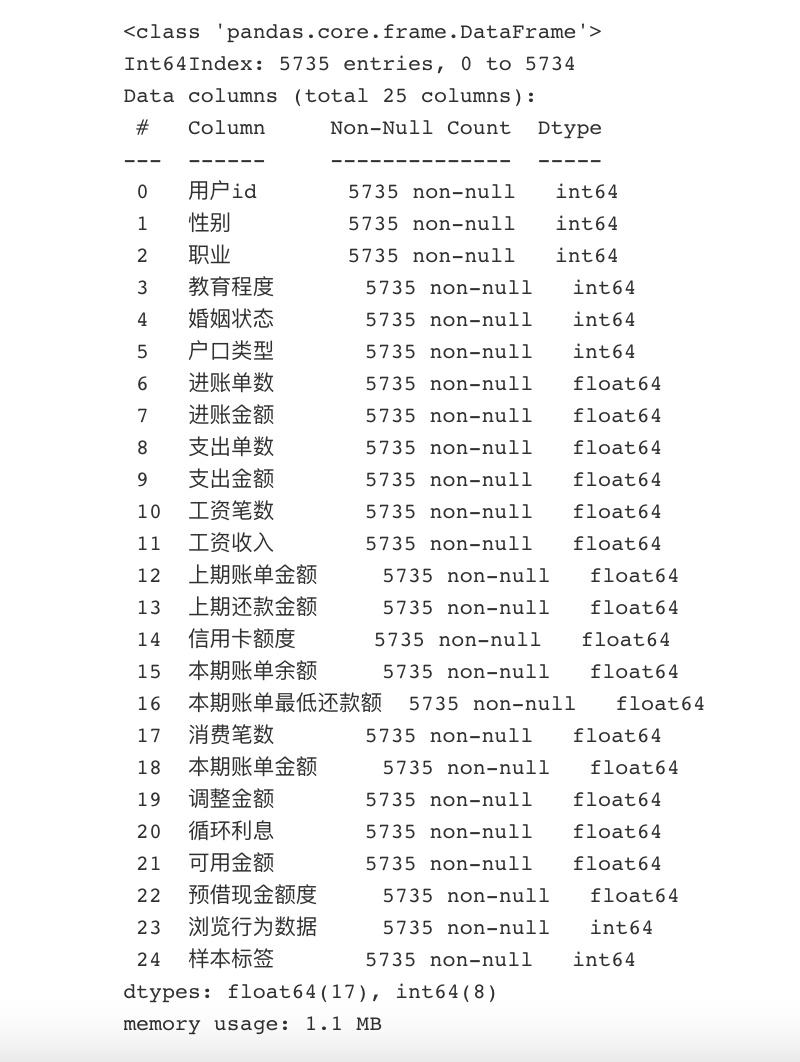

查看完整表格的基本情况,无缺失值,均是数值类型。

df_train.info()

特征工程

基于业务理解的筛选

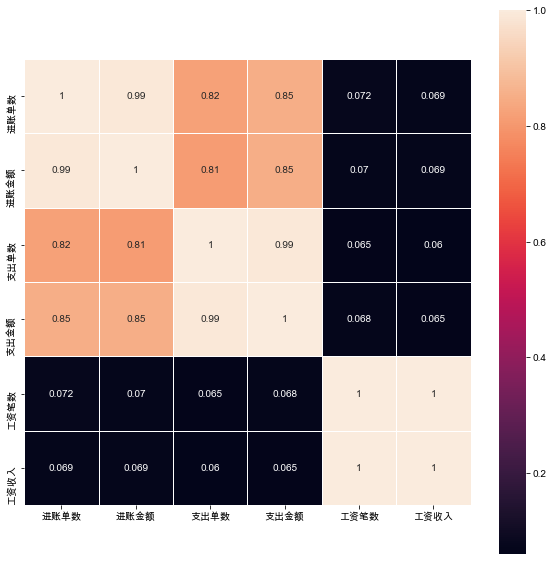

银行流水记录特征相关性分析

# 相关性结果数据表

corrmat=bank_train[internal_chars].corr()

#热力图

sns.heatmap(corrmat, square=True,

linewidths=.5, annot=True);

'进账单数'与'进账金额'的相关系数很高,相关系数为0.99

'支出单数', '支出金额'的相关性较高,相关系数分别为0.82,0.85

'进账金额'与'支出单数', '支出金额'的相关性较高,相关系数分别为0.81,0.85

'支出单数'与 '支出金额'的相关性很高,相关系数为0.99

'工资笔数'与'工资收入'相关系数为1

可见收入、支出、工资三个指标的金额跟笔数是线性关系,那么后续将构建一个新的特征:笔均=金额/笔数,取工资笔均;而且收入、支出是强相关(0.82),所以只取一个即可,支出笔均。

后续将用'进账金额/进账单数','支出金额/支出单数','工资收入/工资笔数'得到'进账笔均','支出笔均','工资笔均'

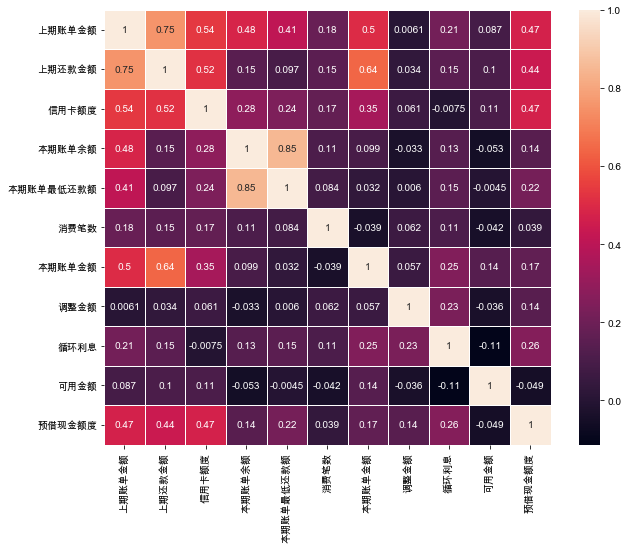

总表相关性分析

# 相关性结果数据表

corrmat=df_train[internal_chars].corr()

# 热力图

sns.heatmap(corrmat, square=False,

linewidths=.5, annot=True);

'本期账单金额'与'本期账单余额'相关系数为0.85

'上期账单金额'与'上期还款金额'相关系数为0.75

'本期账单金额'与'上期还款金额'相关系数为0.64

'信用卡额度'与'上期账单金额'和'上期还款金额'相关系数分别为0.54和0.52

'本期账单金额'与'上期账单金额'相关系数为0.5

本期的账单余额与最低还款额具有高度共线性,决定只选用最低还款额。

生产衍射变量

上期还款差额 =上期账单金额 - 上期还款金额, 上期还款差额还会直接影响用户的信用额度以及本期的账单金额。

调整金额和循环利息是跟“上期的还款差额”有关的:

-

还款差额>0,需要计算循环利息,调整金额不计

-

还款差额<0,需要计算调整金额,循环利息不计

可以将还款差额进行“特征二值化”来代替这两个特征。

预借现金额度,是指持卡人使用信用卡通过ATM等自助终端提取现金的最高额度,取现额度包含于信用额度之内,一般是信用额度的50%左右,所以可以不用这个特征,选择信用额度即可。

df_train['平均支出']=df_train.apply(lambda x:x.支出金额/x.支出单数, axis=1)

df_train['平均工资收入']=df_train.apply(lambda x:x.工资收入/x.工资笔数, axis=1)

df_train['上期还款差额']=df_train.apply(lambda x:x.上期账单金额-x.上期还款金额, axis=1)

df_select=df_train.loc[:,['用户id', '性别', '教育程度', '婚姻状态', '平均支出',

'平均工资收入', '上期还款差额', '信用卡额度', '本期账单余额', '本期账单最低还款额',

'消费笔数', '浏览行为数据', '样本标签']].fillna(0)

df_select.head()

基于机器学习的筛选

将上期还款差额二值化

from sklearn.preprocessing import Binarizer

X=df_select['上期还款差额'].values.reshape(-1,1)

transformer = Binarizer(threshold=0).fit_transform(X)

df_select['上期还款差额标签']=transformer

方差过滤法

过滤那些不带有信息的变量,默认参数为0,即过滤方差为0的那些变量,只保留对模型有贡献的那些信息。

from sklearn.feature_selection import VarianceThreshold

VTS = VarianceThreshold() # 实例化,参数默认方差为0

x_01=VTS.fit_transform(x)

相关性过滤--互信息法

互信息法是用来捕捉每个特征与标签之间的任意关系(包括线性和非线性关系)的过滤方法。

和F检验相似,它既可以做回归也可以做分类,并且包含两个类mutual_info_classif(互信息分类)和mutual_info_regression(互信息回归)。

这两个类的用法和参数都和F检验一模一样,不过互信息法比F检验更加强大,F检验只能够找出线性关系,而互信息法可以找出任意关系。

from sklearn.feature_selection import mutual_info_classif as MIC

result = MIC(x,y)

样本不均衡

通过观察,正负样本比例为 836:4899,属于样本不均衡范畴,可采用上采样的SMOTE算法对其进行样本不均衡处理。

from imblearn.over_sampling import SMOTE

over_samples = SMOTE(random_state=111)

over_samples_x, over_samples_y = over_samples.fit_sample(x,y)

模型建立与调参

文章一开始已经提到过了,可选模型较多,这里举例三种模型逻辑回归、决策树、随机森林模型,其余模型的选用,小伙伴们可以自己动手练习练习。

二分类模型——逻辑回归模型

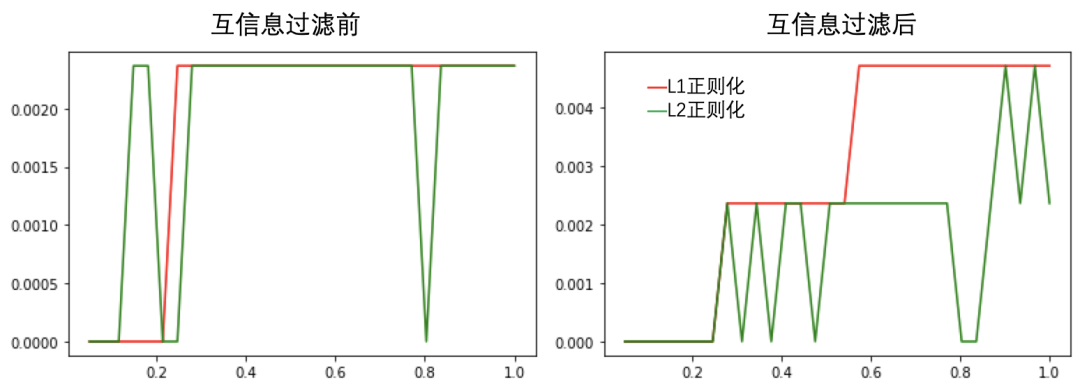

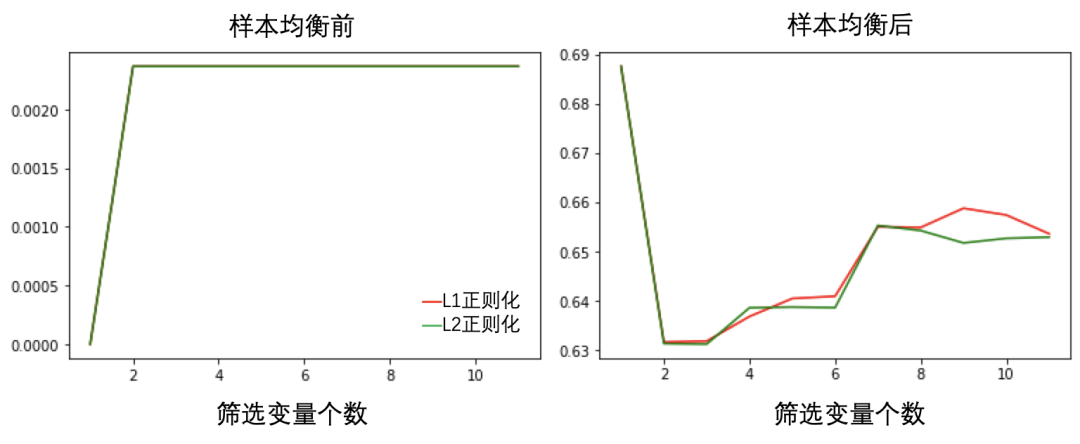

互信息与正则化对模型效果的影响

用学习曲线对参数C进行调整,分别在两个模型中进行调参。

超参数C : 一般不会超过1, 越大惩罚力度越小,本次选取从 0.05 - 2范围。

from sklearn.linear_model import LogisticRegression as LR

from sklearn.model_selection import cross_val_score as cvs

lrl1 = LR(penalty='l1', solver='liblinear',

C=i, max_iter=1000, random_state=0)

lrl2 = LR(penalty='l2', solver='liblinear',

C=i, max_iter=1000, random_state=0)

由图可知,在经过互信息过滤后,逻辑回归模型得分明显提高,且当超参数C=0.6时,模型效果是最好的。

包装法筛选变量

以逻辑回归为基分类器,结合包装法筛选变量,并运用交叉验证绘制学习曲线,探索最佳变量个数。

同时,运用SMOTE算法进行样本均衡处理,并比较均衡前后模型效果的变化。

from sklearn.feature_selection import RFE

LR_1 = LogisticRegression(penalty='l1', solver='liblinear',

C=0.6, max_iter=1000, random_state=0)

selector1 = RFE(LR_1, n_features_to_select=i, step=1)

X_wrapper1 = selector1.fit_transform(x, y)

once1=cvs(LR_1, X_wrapper1, y, cv=5, scoring='f1').mean()

由图可见,样本均衡前后模型效果有大幅度增长。且两种正则化方法相差无几。

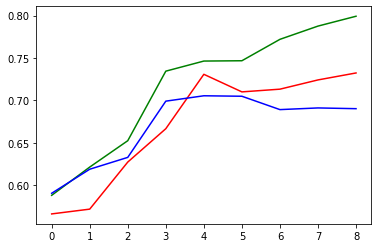

树模型——决策树

因为样本均衡化处理前后,对模型效果提升较为明显,因此在使用决策树模型建立之前,对样本进行均衡化处理。

因为深度参数max_depth是对决策树模型影响最大的参数之一,因此本案例正对决策树深度绘制学习曲线,探索决策树最佳参数。

plt.plot(L_CVS, 'r') # 交叉验证

plt.plot(L_train, 'g')# 训练集

plt.plot(L_test, 'b') # 测试集

由学习曲线可知,在max_depth=5时训练集和测试集模型效果均达到了最佳状态,当在max_depth大于5后,模型在训练集上的分数依然在上升,而测试集上的表现有所下降,这就是模型过拟合现象,因此最终我们选用max_depth=5。

特征重要性

features_imp = pd.Series(dtc.feature_importances_,

index = x.columns).sort_values(ascending=False)

features_imp

上期还款差额标签 0.705916

性别 0.101779

平均支出 0.064218

平均工资收入 0.047644

浏览行为数据 0.044333

教育程度 0.015257

婚姻状态 0.012665

本期账单最低还款额 0.004455

消费笔数 0.003734

本期账单余额 0.000000

信用卡额度 0.000000

dtype: float64

决策树可视化

这里提出一点,如果需要深入理解决策树决策过程,可以借助决策树可视化来辅助理解。

import graphviz

from sklearn import tree

#首先配置

dot_data = tree.export_graphviz(dtc

# 要对已经建成的dct这个实例化好的模型进行画图

,feature_names= x.columns

# 更改列名为中文

# ,class_names=[]

# 更改标签名字

,filled=True

# 给每一个节点分配颜色,颜色约深表示叶子的纯度越高

,rounded=True

# 节点性状为圆角

)

graph = graphviz.Source(dot_data)

graph

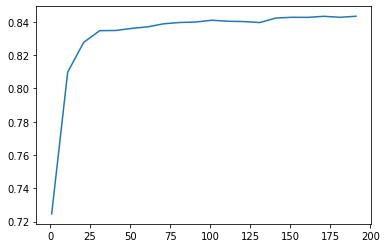

树模型——随机森林

from sklearn.ensemble import RandomForestClassifier as RFC

from sklearn.model_selection import GridSearchCV

rfc = RFC(n_estimators=i+1,

n_jobs=-1,

random_state=90)

score = cvs(rfc,over_samples_x_train,

over_samples_y_train,

cv=5, scoring='f1').mean()

模型调参

有⼀些参数是没有参照的,一开始很难确定⼀个范围,这种情况下采用先通过学习曲线确定参数大致范围,再通过网格搜索确定最佳参数。

比如确定n_estimators范围时,通过学习曲线观察n_estimators在什么取值开始变得平稳,是否⼀直推动模型整体准确率的上升等信息。

对于其他参数也是按照同样的思路,如影响单棵决策树模型的参数max_depth来说,⼀般根据数据的⼤⼩来进⾏⼀个试探,比如乳腺癌数据很⼩,所以可以采⽤1~10,或者1~20这样的试探。

但对于像digit recognition那样的⼤型数据来说,我们应该尝试30~50层深度(或许还不⾜够),此时更应该画出学习曲线,来观察深度对模型的影响。

确定范围后,就可以通过网格搜索的方式确定最佳参数。其他参数就不一一举例了,大家可以动手尝试一下。

# 调整max_depth

param_grid = {'max_depth':np.arange(1, 20, 1)}

rfc = RFC(n_estimators=150,random_state=90, n_jobs=-1)

GS = GridSearchCV(rfc,param_grid,cv=5, scoring='f1')

GS.fit(over_samples_x, over_samples_y)

GS.best_params_

GS.best_score_

模型评价

本次案例模型评估使用classification_report

sklearn中的classification_report函数用于显示主要分类指标的文本报告.在报告中显示每个类的精确度,召回率,F1值等信息。

主要参数:

y_true:1维数组,或标签指示器数组/稀疏矩阵,目标值。y_pred:1维数组,或标签指示器数组/稀疏矩阵,分类器返回的估计值。labels:array,shape = [n_labels],报表中包含的标签索引的可选列表。target_names:字符串列表,与标签匹配的可选显示名称(相同顺序)。sample_weight:类似于shape = [n_samples]的数组,可选项,样本权重。digits:int,输出浮点值的位数。

决策树验证集评价结果

最后这里举了一个决策树模型效果评价的例子,其余分类型模型评价同样可以使用。当然,模型评价方法不止这一种,大家也可以尝试着从其他角度来做模型评价。

precision recall f1-score support

0 0.70 0.74 0.72 1454

1 0.72 0.68 0.70 1454

accuracy 0.71 2908

macro avg 0.71 0.71 0.71 2908

weighted avg 0.71 0.71 0.71 2908

本文旨在梳理数据挖掘的一般过程,没有涉及到很复杂的算法,每个环节,如数据预处理、特征工程、模型建立于评价,均是常用的方法。本文数据也都给大家准备好了。

智能推荐

java把秒时长转换为分钟_java - 将秒值转换为小时分钟秒?-程序员宅基地

文章浏览阅读4.9k次。java - 将秒值转换为小时分钟秒?我一直在尝试将秒值(在BigDecimal变量中)转换为editText中的字符串,如“1小时22分33秒”或类似的东西。我试过这个:String sequenceCaptureTime = "";BigDecimal roundThreeCalc = new BigDecimal("0");BigDecimal hours = new BigDecimal..._java hh:mm:ss转分钟

Sentinel详解_sentinel文档-程序员宅基地

文章浏览阅读966次。Sentinel是阿里开源的项目,提供了流量控制、熔断降级、系统负载保护等多个维度来保障服务之间的稳定性。中文官网地址:https://sentinelguard.io/zh-cn/docs/introduction.html当调用链路中某个资源出现不稳定,则对这个资源的调用进行限制,并让请求快速失败,避免影响到其它的资源。sentinel处理这个问题采取了两中方式:2、下载Sentinelhttps://github.com/alibaba/Sentinel/releases下载完成后找到下载的目录_sentinel文档

360 支持linux版本下载地址,360安全浏览器国产稳定版本发布,提供deb软件包下载,附介绍...-程序员宅基地

文章浏览阅读2.2k次。360安全浏览器已经正式上线国产版,提供有deb软件包下载,为稳定版本(browser360-cn-stable_10.0.2001.0-1_amd64.deb),当前版本号为10.0.2001.0,内核是Chromium 63。有用户反馈,使用-2的有依赖问题,-1没有依赖问题,能正常使用,在下载链接中提供该deb包下载,可参考安装360浏览器稳定版依赖关系不满足的解决思路一文。360安全浏览器..._360deb

cobbler源码安装-程序员宅基地

文章浏览阅读608次。cobbler源码安装1. cobbler简介Cobbler是一个Linux服务器安装的服务,可以通过网络启动(PXE)的方式来快速安装、重装物理服务器和虚拟机,同时还可以管理DHCP,DNS等。Cobbler可以使用命令行方式管理,也提供了基于Web的界面管理工具(cobbler-web),还提供了API接口,可以方便二次开发使用。Cobbler是较早前的kickstart的升级版,优点是比较容易配置,还自带web界面比较易于管理。Cobbler内置了一个轻量级配置管理系统,但它也支持和其它配置_cobbler源码安装

踩雷:Win10安装anaconda3-4.4.0+tensorflow-gpu1.12.0+keras2.2.4_anaconda3 4.4.0-程序员宅基地

文章浏览阅读477次。**Win10安装anaconda3-4.4.0+tensorflow-gpu1.12.0+keras2.2.4**本人的电脑配置:NVIDIA GTX1050ti这次安装也是破费周转,特此做下记录。不会再详细地写出具体的操作,大多数都用链接代替了。1.安装anacondaWindows安装anaconda2.安装cuda下载cudnntensorflow各个版本的CUDA以及Cudnn版本对应关系首先要清楚自己需要装什么版本的tensorflow。根据自己项目的实际需求确定tensorf_anaconda3 4.4.0

阿里云ACP认证考试过关心得经验及考试费用详解 ...-程序员宅基地

文章浏览阅读5.5k次,点赞2次,收藏6次。阿里云ACP专业认证考试值得考吗?当然值得!云吞铺子来说说ACP认证考试过关心得、经验分享、考试费用、报名考场等相关问题:ACP认证种类范围ACP认证可以分为五个领域,即云计算、大数据、云安全、人工智能和中间件。目前阿里云ACP认证考试分为:云计算工程师、大数据分析师和大数据工程师、云安全工程师和云安全行业工程师、人工智能工程师和企业级互联网架构工程..._阿里云acp考试没过要重新交费吗

随便推点

Unknown URL-程序员宅基地

文章浏览阅读1.8k次。菜鸟错误大全(六)我们都是从新手一步一个坑踩过来的,下面我们来讲讲会遇到的常见错误和解决办法: Unknown URL content://com.exaple.databasetest.provider/book:这是写错包名了,应该为“content://com.example.databasetest.provider/book”_unknown url

【微信小程序】支付及退款流程详解_微信小程序退款前端开发-程序员宅基地

文章浏览阅读2.5k次,点赞2次,收藏15次。一. 支付支付主要分为几个步骤:前端携带支付需要的数据(商品id,购买数量等)发起支付请求后端在接收到支付请求后,处理支付数据,然后携带处理后的数据请求 微信服务器 的 支付统一下单接口后端接收到上一步请求微信服务器的返回数据,再次处理,然后返回前端让前端可以开始支付。前端进行支付动作前端支付完成后,微信服务器会向后端发送支付通知(也就是微信要告诉你客户已经付过钱了),后端根据这个通..._微信小程序退款前端开发

Sublime Text 3正式版发布_sublime3 toolchain-程序员宅基地

文章浏览阅读2.2w次。Sublime Text 3正式版发布作者:chszs,转载需注明。博客主页:http://blog.csdn.net/chszs一、下载地址:1. Windows 32位版http://c758482.r82.cf2.rackcdn.com/Sublime%20Text%20Build%203010%20Setup.exe2. Windows 64位版http://c758482.r82.cf2_sublime3 toolchain

flutter 参数函数_Flutter完整开发实战详解(一、基础)-程序员宅基地

文章浏览阅读776次。前言在如今的 Flutter 大潮下,本系列是让你看完会安心的文章。本系列将完整讲述:如何入门 Flutter 开发,如何快速从 0 开发一个完整的 Flutter APP,配套高完成度 Flutter 开源项目 GSYGithubAppFlutter,提供 Flutter 的开发技巧和问题处理,之后深入源码和实战为你全面解析 Flutter。 笔者相继开发过 Flutter、React Nat..._flutter 函数详解

Java实现第八届蓝桥杯杨辉三角-程序员宅基地

文章浏览阅读3.5k次。杨辉三角杨辉三角也叫帕斯卡三角,在很多数量关系中可以看到,十分重要。第0行: 1第1行: ..._杨辉三角java第八届蓝桥杯

硕士阶段人工智能有哪些比较好的发论文的方向?_硕士强化学习做什么方向好毕业-程序员宅基地

文章浏览阅读3.7k次。人们对于一些新时代诞生得词语总是会提出疑问,比如说什么是人工智能?在帮助盟军通过破解纳粹加密机Enigma赢得第二次世界大战后不到十年,数学家艾伦·图灵(Alan Turing)第二次改变了历史,提出了一个简单的问题:“机器能思考吗?”图灵1950年的论文“计算机与智能”及其随后的图灵测试确立了人工智能的基本目标和愿景。从本质上讲,人工智能是计算机科学的一个分支,旨在肯定地回答图灵的问题。它是在机器中复制或模拟人类智能的努力。人工智能的广泛目标引发了许多问题和辩论如此之多,以至于没有一个单一的领域定义被_硕士强化学习做什么方向好毕业